前言

在云原生社区及更广泛的技术领域中,eBPF 已成为近年来最热门的技术话题之一。在网络、安全、可观察性等领域,新一代强大的工具和项目正基于 eBPF 平台构建(并不断涌现)。相比从前,它们提供了更好的性能和精度。诸如 eBPF 峰会和云原生 eBPF 日等 eBPF 相关会议吸引了成千上万的与会者和观众,截至撰写本文时,eBPF Slack 社区已有超过 14,000 名成员。

为何 eBPF 被选为众多基础设施工具的底层技术?它如何实现所承诺的性能提升?eBPF 如何在从性能追踪到网络流量加密等各不相同的技术领域中发挥作用?

本书旨在解答这些问题,通过让读者了解 eBPF 的工作原理,并提供编写 eBPF 代码的入门介绍。

这本书适合谁

本书适用于对 eBPF 感兴趣并希望深入了解其工作原理的开发者、系统管理员、运维人员和学生。它为那些希望自己编写 eBPF 程序的人提供了基础。由于 eBPF 为新一代的基础设施和工具提供了卓越的平台,因此未来几年内,eBPF 开发者将可能有很好的就业机会。

即使您并不打算亲自编写 eBPF 代码,本书对您仍然有用。如果您在运维、安全或任何涉及软件基础设施的角色中工作,现在或未来几年内,您很可能会接触到基于 eBPF 的工具。了解这些工具的内部工作原理将使您能够更有效地使用它们。例如,如果您知道事件是如何触发 eBPF 程序的,您将能够更好地理解基于 eBPF 的工具在显示性能指标时究竟在测量什么。如果您是一名应用开发者,您也可能会接触到一些基于 eBPF 的工具——例如,当您进行应用性能调优时,可能会使用像 Parca 这样的工具生成火焰图,显示哪些函数耗时最多。如果您在评估安全工具,本书将帮助您理解 eBPF 的优势所在,以及如何避免以一种天真的方式使用它,导致其对攻击的防御效果降低。

即使您现在并没有使用 eBPF 工具,我也希望本书能为您提供一些有趣的见解,让您了解 Linux 的一些您可能从未考虑过的领域。大多数开发者将内核视为理所当然,因为他们使用编程语言提供的便利高级抽象,使他们能够专注于应用开发工作——这已经足够艰难了!他们使用调试器和性能分析器等工具来有效地完成工作。了解调试器或性能工具的内部工作原理可能很有趣,但并非必不可少。然而,对许多人来说,深入挖掘以了解更多是有趣且充实的1。同样,大多数人会使用 eBPF 工具,而无需关心它们是如何构建的。正如 Arthur C. Clarke 所说,“任何足够先进的技术都与魔法无异”。但就我个人而言,我喜欢深入研究,找出魔法背后的原理。您可能和我一样,觉得有必要探索 eBPF 编程,以更好地了解这项技术的潜力。如果是这样,我相信您会喜欢这本书。

本书涵盖的内容

eBPF 正以相当快的速度不断发展,这使得撰写一部不需频繁更新的全面参考书变得相当困难。然而,有些基本原理和基础原则不太可能发生显著变化,这正是本书所讨论的内容。

第 1 章为本书奠定基础,介绍了 eBPF 这项技术为何如此强大,并解释了在操作系统内核中运行自定义程序如何实现诸多令人兴奋的功能。

在第 2 章中,内容变得更具体,您将看到一些 “Hello World” 的示例,向您介绍 eBPF 程序和映射(maps)的概念。

第 3 章深入探讨 eBPF 程序及其在内核中的运行方式,而第 4 章则探讨用户空间应用程序与 eBPF 程序之间的接口。

近年来,eBPF 的一大挑战是跨内核版本的兼容性问题。第 5 章介绍了解决这一问题的“一次编译,到处运行”(compile once, run everywhere,CO-RE)方法。

验证过程也许是区分 eBPF 和内核模块的最重要特征。我将在第 6 章中向您介绍 eBPF 验证器。

在第 7 章中,您将了解许多不同类型的 eBPF 程序及其附加点(attachment points)。其中许多附加点位于网络协议栈中,第 8 章将更详细地探讨了 eBPF 在网络功能中的应用。第 9 章则探讨了 eBPF 在构建安全工具方面的应用。

如果您想编写与 eBPF 程序交互的用户空间应用程序,有许多可用的库和框架来提供帮助。第 10 章概述了各种编程语言的选项。

最后,在第 11 章,我将展望 eBPF 领域可能出现的一些未来发展。

前置知识

本书假设您对 Linux 的基本 shell 命令和使用编译器将源代码转换为可执行程序的概念感到熟悉。书中包含一些简单的 Makefile 示例,假设您至少对 make 如何使用这些文件有最基本的了解。

书中有大量的 Python、C 和 Go 语言的代码示例。您不需要深入掌握这些语言即可从示例中获益,但如果您乐于阅读一些代码,您将能从本书中获得更多收益。我还假设您熟悉指针的概念,它用来标识内存位置。

示例代码和练习

本书包含大量的代码示例。如果您希望亲自尝试这些示例,可以访问 https://github.com/lizrice/learning-ebpf 获取配套的 GitHub 仓库及安装和运行代码的说明。

我还在大多数章节的末尾附上了练习,帮助您通过扩展示例或编写自己的程序来探索 eBPF 编程。

由于 eBPF 不断发展,您可用的特性取决于您运行的内核版本。许多适用于早期版本的限制在后来的版本中已被解除或放宽。Iovisor 项目提供了不同 BPF 特性在各内核版本中添加情况的有用概述,本书中我尽量注明了所描述特性被添加的具体版本。这些示例在 5.15 版本的内核上进行了测试,但在撰写本文时,一些流行的 Linux 发行版尚未支持如此新的内核版本。如果您在本书刚出版时阅读,可能会发现某些特性在您的生产环境所用的 Linux 内核上无法运行。

eBPF 只适用于 Linux 吗?

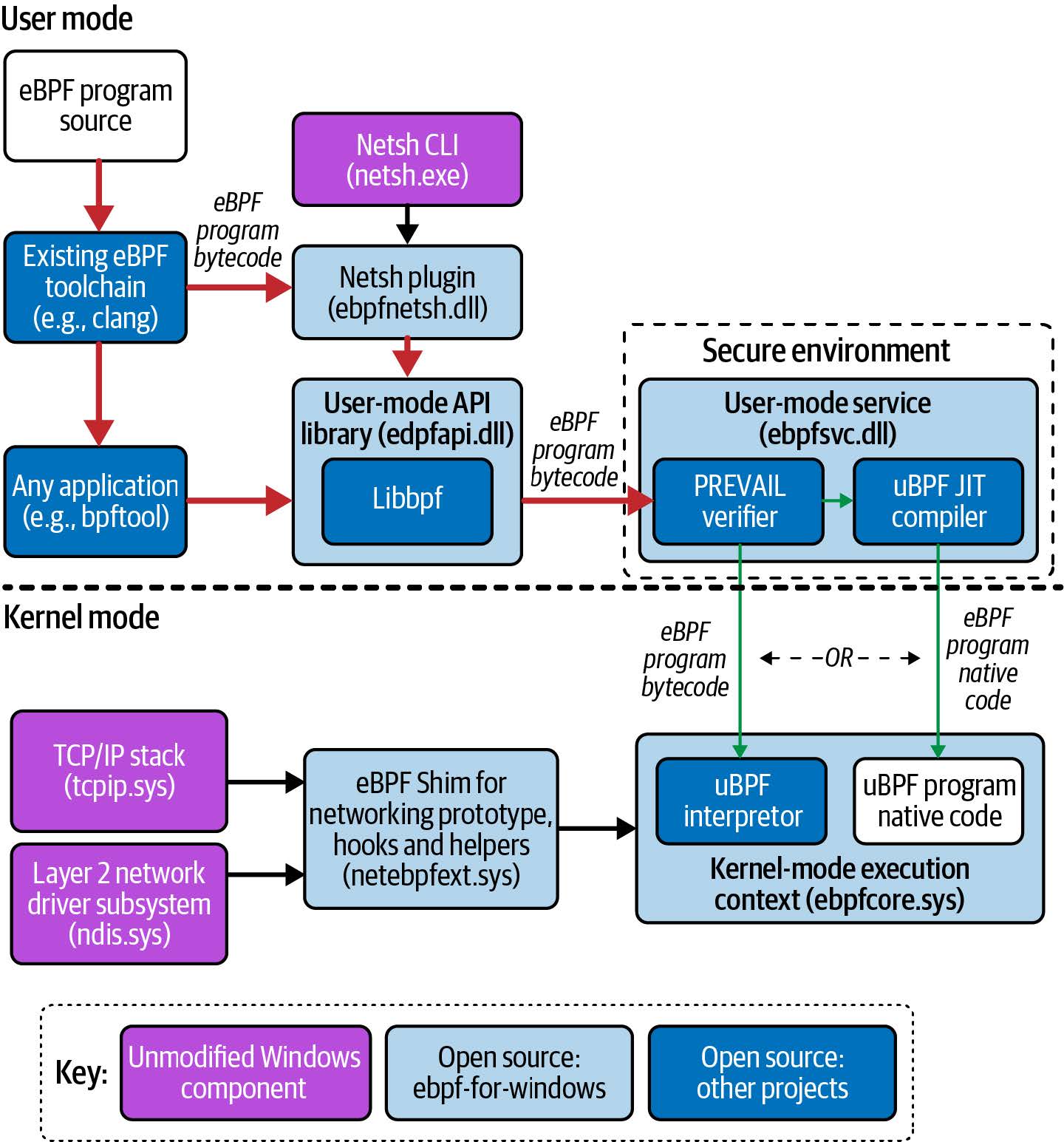

eBPF 最初是为 Linux 开发的。实际上,这种方法完全可以应用于其他操作系统——事实上,微软已经正在开发基于 Windows 平台的 eBPF 实现。我在第 11 章简要讨论了这一点,但本书其余部分将重点关注 Linux 的实现,所有示例也都基于 Linux。

本书中使用的约定

本书中使用了以下排版约定:

-

斜体:用于表示新术语、URL、电子邮件地址、文件名和文件扩展名。

-

等宽字体:用于程序列表,以及在段落中引用程序元素,如变量或函数名、数据库、数据类型、环境变量、语句和关键字。 -

等宽粗体:显示用户应逐字输入的命令或其他文本。 -

等宽斜体:显示应由用户提供的值或由上下文确定的值。

tip

此元素表示提示或建议。

note

此元素表示一般说明。

warning

此元素表示警告或注意事项。

在2017年巴黎的dotGo会议上,我做了一场展示调试器工作原理的演讲。

第 1 章 什么是 eBPF,为何它如此重要?

eBPF 是一种革命性的内核技术,允许开发者编写自定义代码并动态加载到内核中,从而改变内核的行为。(如果您对内核的概念不太自信,不用担心——我们将在本章稍后进行介绍。)

这种技术使得新一代高性能网络、可观察性和安全工具成为可能。正如您将看到的,如果您想用这些基于 eBPF 的工具来检测应用程序,您不需要以任何方式修改或重新配置应用程序,这要归功于 eBPF 在内核中的优势地位。

使用 eBPF,您可以做的事情包括但不限于:

- 对系统几乎任何方面的性能追踪

- 高性能网络,具有内置的可见性

- 检测并(可选地)阻止恶意活动

让我们从伯克利数据包过滤器(Berkeley Packet Filter)开始,简要回顾一下 eBPF 的历史。

eBPF 的起源:伯克利数据包过滤器

我们今天所说的 "eBPF" 起源于 BSD 数据包过滤器,最早由劳伦斯伯克利国家实验室的 Steven McCanne 和 Van Jacobson 在 1993 年的一篇论文1中描述。该论文讨论了一种能够运行过滤器的伪机器,这些过滤器是用来决定是否接受或拒绝网络数据包的程序。这些程序是用 BPF 指令集编写的,这是一组通用的 32 位指令,与汇编语言非常相似。以下是直接取自该论文的一个示例:

ldh [12]

jeq #ETHERTYPE IP, L1, L2

L1: ret #TRUE

L2: ret #0

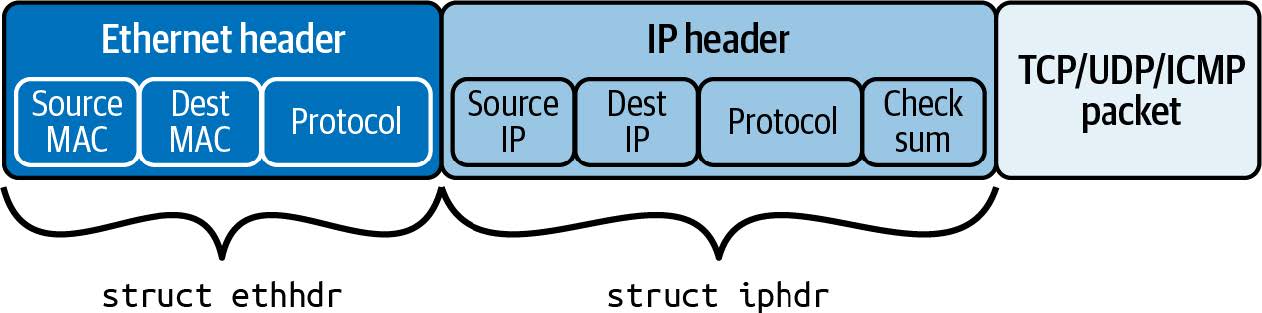

这段简短的代码过滤掉不是互联网协议(IP 协议)的数据包。该过滤器的输入是一个以太网数据包,第一条指令(ldh)从该数据包的第 12 字节开始加载一个 2 字节的值。接下来的指令(jeq)将该值与代表 IP 数据包的值进行比较。如果匹配,则执行跳转到标记为 L1 的指令,并通过返回一个非零值(这里标识为 #TRUE)来接受数据包。如果不匹配,则数据包不是 IP 数据包,通过返回 0 来拒绝该数据包。

您可以想象(或参考该论文找到示例)更复杂的过滤程序,这些程序基于数据包的其他方面做出决定。重要的是,过滤器的作者可以编写自己的自定义程序在内核中执行,而这正是 eBPF 的核心功能。

BPF 代表“Berkeley Packet Filter”,它首次引入 Linux 是在 1997 年的内核版本 2.1.75 中2,用于 tcpdump 工具中,作为一种高效的捕获数据包的方法。

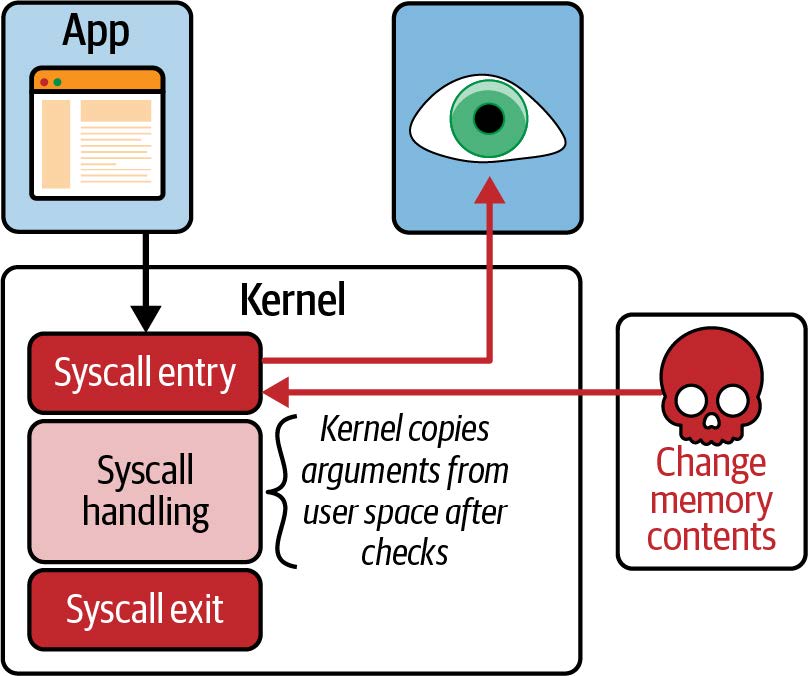

时间快进到 2012 年,seccomp-bpf 在内核版本 3.5 中引入。这使得可以使用 BPF 程序来决定是否允许用户空间应用程序进行系统调用。我们将在第 10 章中详细探讨这一点。这是将 BPF 从数据包过滤的狭窄范围演变为今天的通用平台的第一步。从此之后,名称中的“数据包过滤器”一词开始变得不那么有意义!

从 BPF 到 eBPF

从 2014 年的内核 3.18 版本开始,BPF 演变为我们所说的 "extended BPF" 或 "eBPF"。这涉及到几项重大变更:

- 为了在 64 位机器上更高效的运行,BPF 指令集被彻底改造,解释器也被完全重写。

- 引入了 eBPF 映射(maps),这是可以由 BPF 程序和用户空间应用程序访问的数据结构,允许在它们之间共享信息。您将在第 2 章中了解映射。

- 添加了

bpf()系统调用,以便用户空间程序可以与内核中的 eBPF 程序进行交互。您将在第 4 章中阅读到关于这个系统调用的内容。 - 增加了几个 BPF 辅助函数。您将在第 2 章中看到一些示例,并在第 6 章中了解更多细节。

- 增加了 eBPF 验证器,以便确保 eBPF 程序可以安全运行。这将在第 6 章中讨论。

这些变化奠定了 eBPF 的基础,但发展并没有放缓!自那以后,eBPF 取得了显著的发展。

eBPF 向生产系统的演变

自 2005 年以来,Linux 内核中一直存在一种名为 kprobes(内核探针)的特性,允许在内核代码的几乎任何指令上设置陷阱(traps)。开发者可以编写内核模块,将函数附加到 kprobes 上,用于调试或性能测量3。

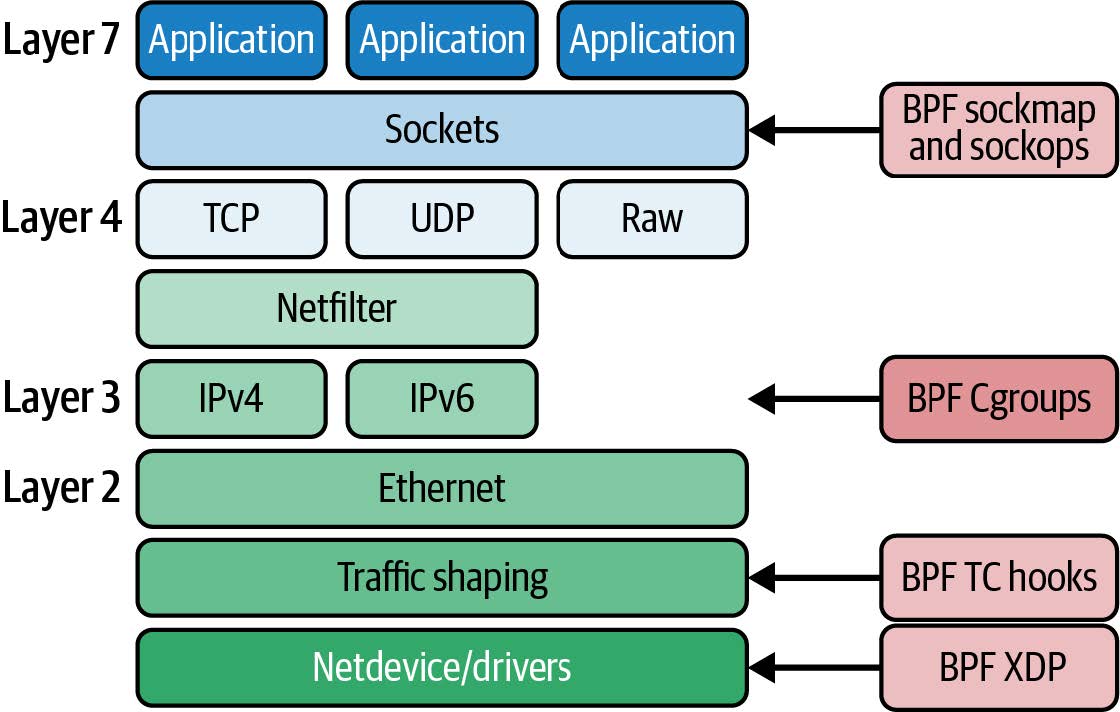

2015 年,添加了将 eBPF 程序附加到 kprobes 的功能,这开启了 Linux 系统中追踪方式的革命性变革。同时,内核的网络协议栈中开始添加钩子(hooks),允许 eBPF 程序处理更多的网络功能。在第 8 章中,我们将详细探讨这一点。

到 2016 年,基于 eBPF 的工具已在生产系统中使用。Brendan Gregg在 Netflix 的追踪工作在基础设施和运维领域中广为人知,他曾表示eBPF“为 Linux 带来了超能力”。同年,Cilium 项目宣布成立,这是第一个使用 eBPF 替换容器环境中整个数据路径的网络项目。

接下来的一年,Facebook(现在是 Meta)将 Katran 项目开源。Katran 是一个四层负载均衡器,满足了 Facebook 对高度可扩展和快速的解决方案的需求。自 2017 年以来,所有发送到 Facebook.com 的数据包都通过 eBPF/XDP 进行处理。(这一精彩事实来自 Daniel Borkmann 在 KubeCon 2020 上发表的题为 “eBPF 和 Kubernetes:用于扩展微服务的小助手”。)对我个人而言,这一年点燃了我对这项技术所带来可能性的兴奋,因为我在德克萨斯州奥斯汀的 DockerCon 上看到了 Thomas Graf 关于 eBPF 和 Cilium 项目的演讲。

次年,Facebook(现在是 Meta)将Katran开源。Katran 是一个四层负载均衡器,满足了 Facebook 对高度可扩展和快速解决方案的需求。自 2017 年以来,每一个访问Facebook.com的数据包都通过了 eBPF/XDP4。对我个人而言,这一年点燃了我对这种技术可能性的热情,在得克萨斯州奥斯汀的 DockerCon 上听到Thomas Graf 关于 eBPF 和 Cilium 项目的演讲后尤为如此。

2018 年,eBPF 成为 Linux 内核中的一个独立子系统,由来自 Isovalent 的Daniel Borkmann和来自 Meta 的Alexei Starovoitov担任维护者(后来同样来自 Meta 的 Andrii Nakryiko 加入了他们)。同年,引入了 BPF 类型格式(BTF),使得 eBPF 程序更具可移植性。我们将在第 5 章中探讨这一点。

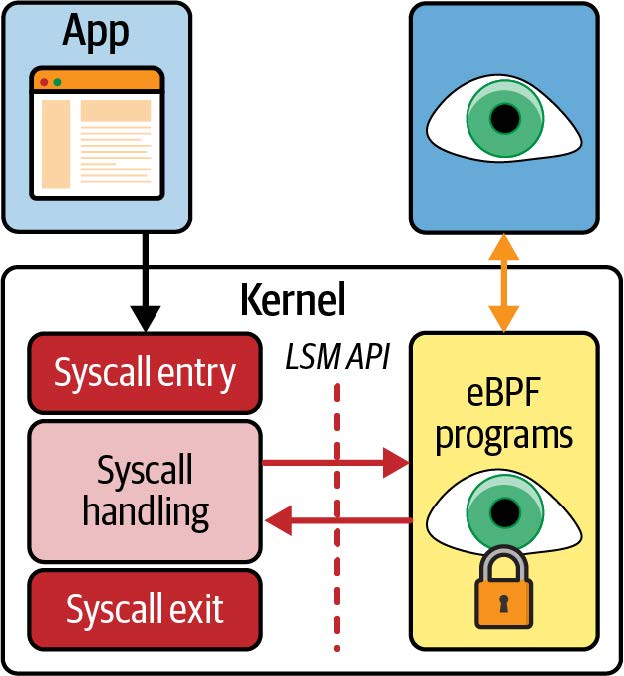

2020 年引入了 LSM BPF,允许 eBPF 程序附加到 Linux 安全模块 (Linux Security Module,LSM) 内核接口。这表明 eBPF 的第三个主要用途已经确定:除了网络和可观察性之外,eBPF 还成为了安全工具的优秀平台。

多年来,得益于 300 多名内核开发者以及众多相关用户空间工具(如第 3 章中会介绍的 bpftool)、编译器和编程语言库的贡献,eBPF 的功能得到了显著提升。程序曾经被限制为 4,096 条指令,但如今这一限制已增加到 100 万条经过验证的指令5,并且通过对尾调用(tail calls)和函数调用的支持(将在第 2 章和第 3 章中看到),这一限制实际上变得无关紧要。

note

要深入了解 eBPF 的历史,最好参考那些从一开始就致力于此的维护者。

Alexei Starovoitov 曾发表过一场引人入胜的演讲,讲述了 BPF 从软件定义网络(SDN)起源的发展历程。在这次演讲中,他讨论了早期 eBPF 补丁被接受到内核中的策略,并透露 eBPF 的正式生日是 2014 年 9 月 26 日,这标志着包括验证器、BPF 系统调用和映射的第一组补丁的接受。

Daniel Borkmann 也讨论了 BPF 的历史及其支持网络和追踪功能的演变。我强烈推荐他题为“eBPF 和 Kubernetes: 用于扩展微服务的小助手”的演讲,其中充满了有趣的信息。

艰难的命名

eBPF 的应用范围已经远远超出了数据包过滤的范畴,因此这个缩写现在本质上已经失去了意义,它已经成为一个独立的术语。由于当前广泛使用的 Linux 内核都对 "extended" 部分提供支持,因此 eBPF 和 BPF 这两个术语通常可以互换使用。在内核源代码和 eBPF 编程中,常用的术语是 BPF。例如,在第 4 章中我们会看到,与 eBPF 进行交互的系统调用是bpf(),辅助函数以bpf_开头,不同类型的(e)BPF 程序以BPF_PROG_TYPE开头的名称进行标识。在内核社区之外,"eBPF"这个名称似乎已经被广泛使用,例如在社区网站 ebpf.io 上和 eBPF 基金会的名称中都使用了这个术语。

eBPF 的应用范围远远超出了数据包过滤的范畴,以至于这个缩写如今基本上没有实际意义,已经成为一个独立的术语。而且,由于目前广泛使用的 Linux 内核都支持“扩展(extended)”部分,因此 eBPF 和 BPF 的术语基本上可以互换使用。在内核源代码和 eBPF 编程中,常用的术语是 BPF。例如,正如我们将在第 4 章中看到的,与 eBPF 交互的系统调用是 bpf(),辅助函数以 bpf_ 开头,不同类型的 (e)BPF 程序以 BPF_PROG_TYPE 开头。在内核社区之外,“eBPF”这个名称似乎已经被固定下来,例如,在社区网站 ebpf.io 和 eBPF 基金会的名称中都使用了这个术语。

Linux 内核

要理解 eBPF,您需要对 Linux 中内核空间和用户空间之间的区别有深入的了解。我在我的报告“什么是 eBPF?(What Is eBPF?)”6中谈到了这一点,并将其中的一些内容进行调整,形成接下来的几个段落。

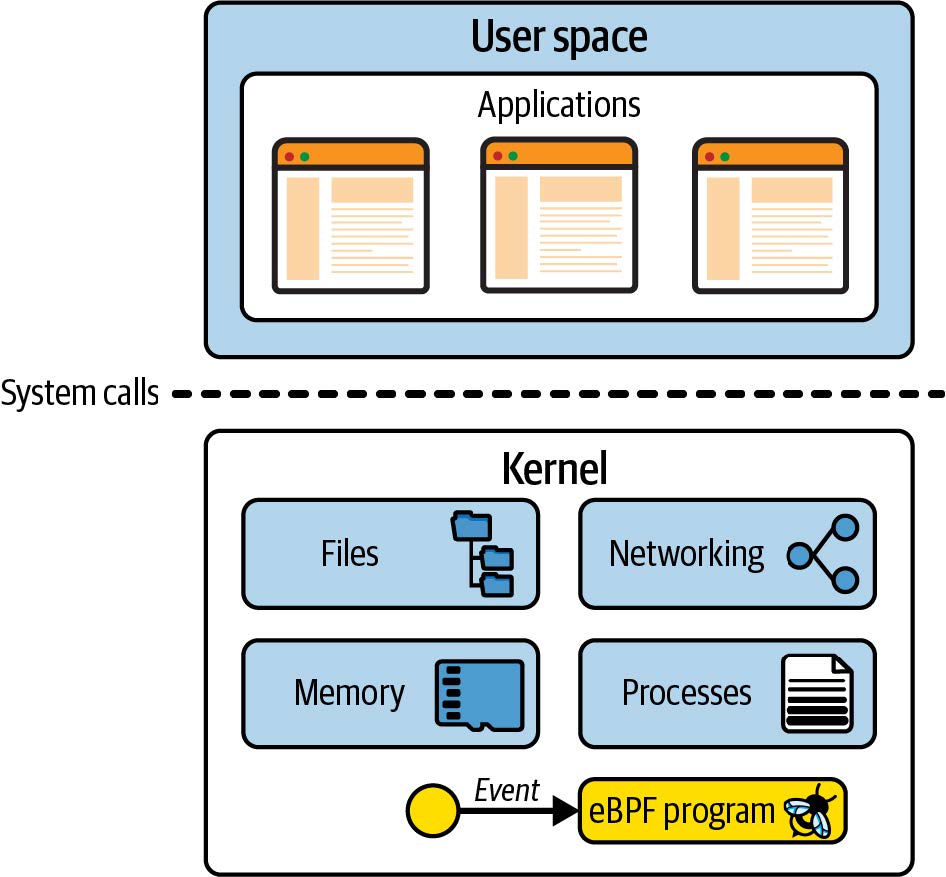

Linux 内核是应用程序与其运行的硬件之间的软件层。应用程序运行在一个称为*用户空间(user space)*的非特权层,无法直接访问硬件。相反,应用程序使用系统调用(syscall)接口请求内核代表其执行操作。硬件访问可能涉及读取和写入文件、发送或接收网络流量,甚至只是访问内存。内核还负责协调并发进程,使许多应用程序能够同时运行。如图 1-1 所示。

作为应用程序开发者,我们通常不直接使用系统调用接口,因为编程语言为我们提供了更高级的抽象和更易编程的标准库。因此,很多人对内核在我们的程序运行时所做的大量工作并不知情。如果您想了解内核被调用的频率,可以使用 strace 工具显示应用程序进行的所有系统调用。

图 1-1. 用户空间中的应用程序通过系统调用接口向内核发出请求

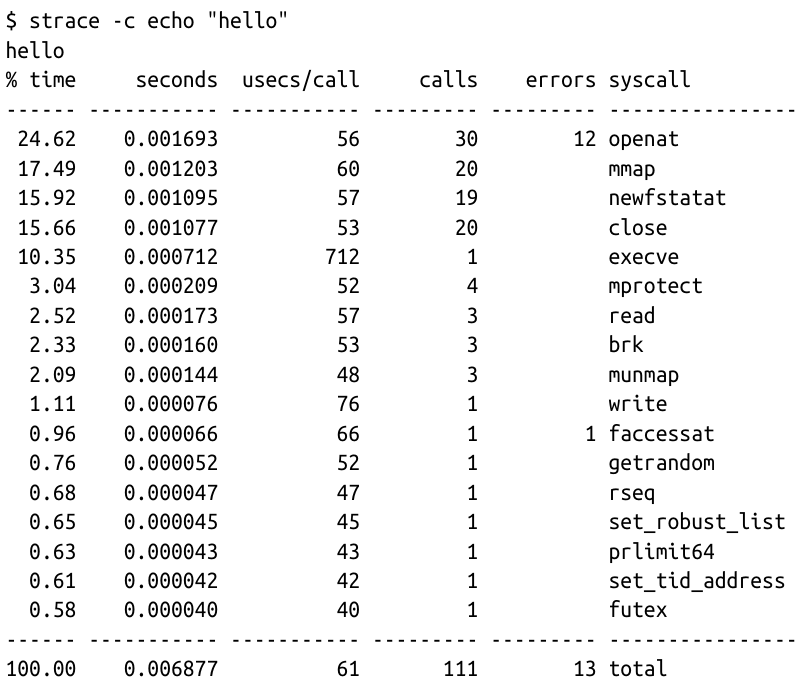

以下是一个示例,使用 cat 命令将“hello”这个词回显到屏幕上,涉及超过 100 次系统调用:

由于应用程序严重依赖内核,这意味着如果我们能够观察应用程序与内核的交互,我们可以了解很多关于应用程序行为的信息。通过 eBPF,我们可以在内核中添加检测点来获得观察能力。

例如,如果您能拦截打开文件的系统调用,您就可以准确地查看任何应用程序访问了哪些文件。但是,如何进行拦截呢?让我们考虑一下,如果我们想修改内核,添加新代码,在每次调用该系统调用时创建某种输出,会涉及到什么问题。

向内核添加新功能

Linux 内核非常复杂,截至撰写本文时,代码量大约为 3000 万行7。对任何代码库进行更改都需要对现有代码有一定的熟悉程度,因此除非您已经是内核开发者,否则这可能会是一个挑战。

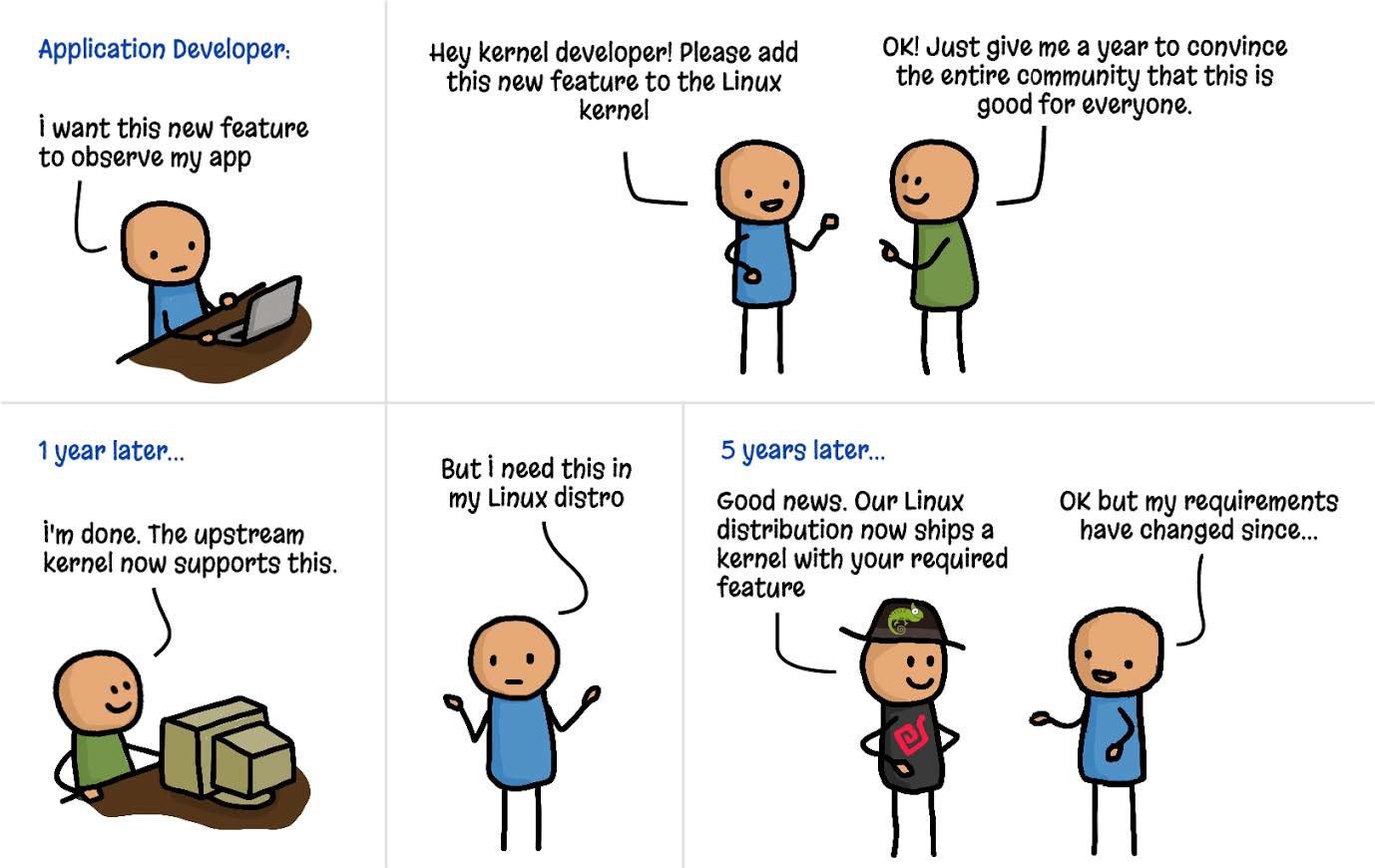

此外,如果您想将您的更改贡献到上游,您将面临的不仅仅是技术挑战。Linux 是一个通用操作系统,用于各种环境和情况下。这意味着,如果您希望您的更改成为官方 Linux 版本的一部分,那就不是简单的编写代码就可以了。该代码必须被社区(更具体地说,是 Linux 的创建者 Linus Torvalds 和主要开发者)接受,认为这一更改对所有人都有益。这并不是理所当然的——提交的内核补丁中只有三分之一被接受8。

假设您已经找到了一个良好的技术方法来拦截打开文件的系统调用。经过数月的讨论和您的辛勤开发工作,假设您的更改被接受到内核中。太棒了!但这项更改何时才能到达每个人的机器上呢?

Linux 内核每两到三个月发布一个新版本,但即使某个更改被纳入这些版本中的一个,它离大多数人的生产环境中可用还有一段时间。这是因为大多数人并不直接使用 Linux 内核——我们使用的是像 Debian、Red Hat、Alpine 和 Ubuntu 这样的 Linux 发行版,这些发行版将 Linux 内核与各种其他组件一起打包。您很可能会发现您最喜欢的发行版使用的是几年前的内核版本。

例如,很多企业用户使用 Red Hat Enterprise Linux(RHEL)。截至撰写本文时,当前版本是 2021 年 11 月发布的 RHEL 8.5,它使用的是 2018 年 8 月发布的 Linux 内核版本 4.18。

正如图 1-2 中的漫画所示,从想法阶段到将新功能纳入生产环境的 Linux 内核中,需要数年的时间9。

图 1-2. 向内核添加功能(插图由 Isovalent 的 Vadim Shchekoldin 绘制)

内核模块

如果您不想等待数年才能将更改纳入内核,还有另一种选择。Linux 内核被设计允许接受内核模块(Kernel Modules),这些模块可以按需加载和卸载。如果您想更改或扩展内核行为,编写一个模块无疑是一种方法。内核模块可以独立于官方的 Linux 内核发布而进行分发,因此无需被接受到主要的上游代码库中。

这里最大的挑战在于,这仍然是完全的内核编程。用户历来对使用内核模块非常谨慎,原因很简单:如果内核代码崩溃,整台机器及其上运行的所有程序都会崩溃。用户如何确信内核模块是安全的?

“安全运行”不仅意味着不会崩溃——用户还希望知道内核模块在安全性方面是可靠的。它是否包含攻击者可以利用的漏洞?我们是否信任模块的作者不会在其中加入恶意代码?由于内核是特权代码,它可以访问机器上的所有内容,包括所有数据,因此内核中的恶意代码将是一个严重的问题。这同样适用于内核模块。

内核安全性是 Linux 发行版需要很长时间才能引入新版本的一个重要原因。如果其他人在各种情况下运行某个内核版本数月或数年,这应该已经排除了问题。发行版维护者可以相对自信地认为,他们提供给用户/客户的内核是经过*加固(hardened)*的——即安全运行的。

eBPF 提供了一种非常不同的安全方法:eBPF 验证器(eBPF verifier),确保只有在安全运行的情况下才能加载 eBPF 程序——它不会导致机器崩溃或陷入死循环,也不会允许数据被泄露。我们将在第 6 章中更详细地讨论验证过程。

eBPF 程序的动态加载

eBPF 程序可以动态地加载到内核中和从内核中移除。一旦它们被附加到某个事件上,无论是什么原因触发该事件,它们都会被触发。例如,如果您将程序附加到打开文件的系统调用上,只要任何进程尝试打开文件,该程序就会被触发。无论该进程是在程序加载时就已经运行,还是之后才运行,都无关紧要。与升级内核后需要重启机器才能使用新功能相比,这是一个巨大的优势。

这引出了使用 eBPF 的可观察性或安全工具的一个巨大优势——它可以立即获得对机器上所有活动的可见性。在运行容器的环境中,这包括对所有在这些容器内运行的进程以及主机上的进程的可见性。在本章稍后部分,我将深入探讨这对云原生部署的影响。

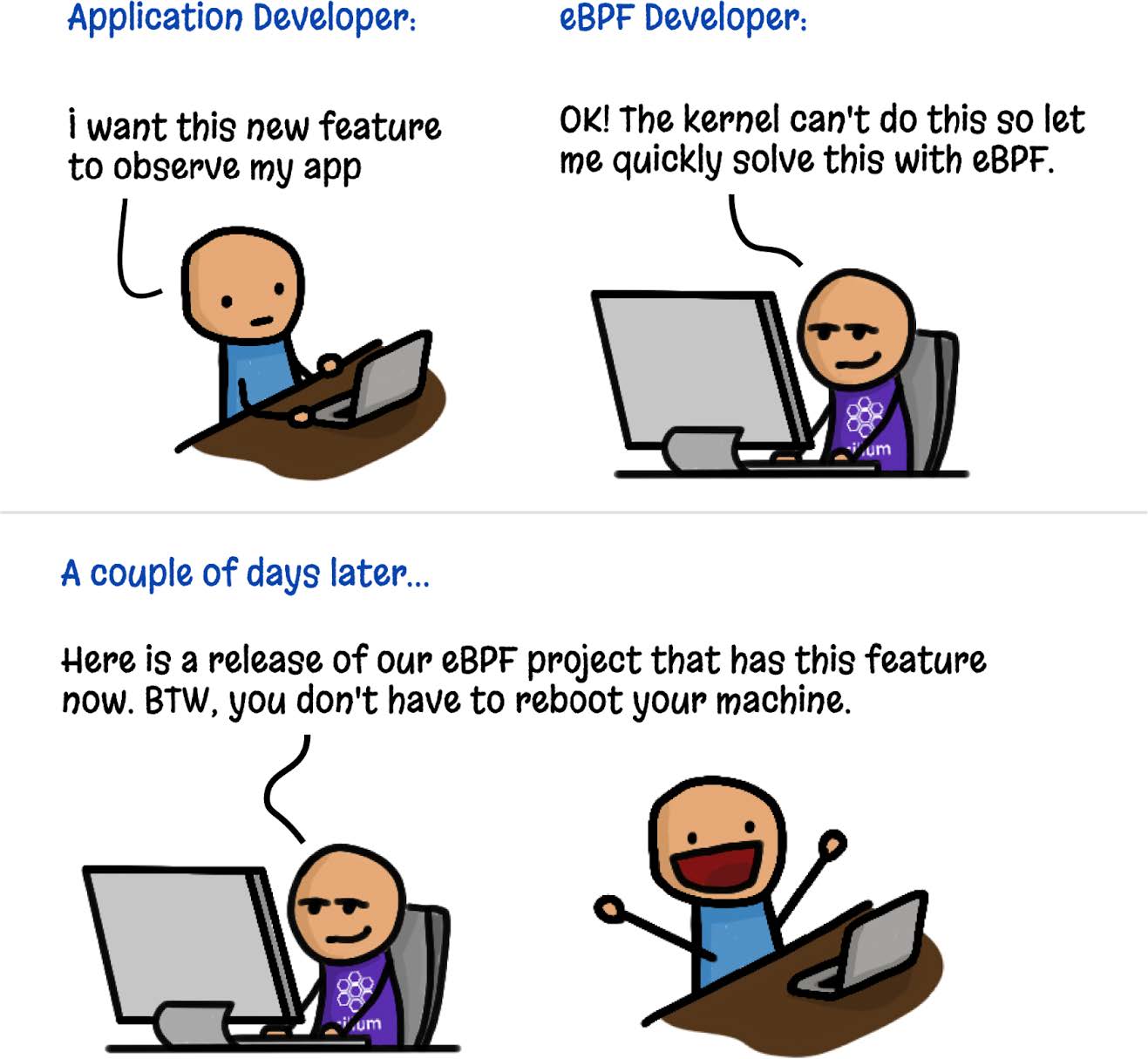

此外,如图 1-3 所示,人们可以通过 eBPF 非常快速地创建新的内核功能,而不需要每个 Linux 用户都接受相同的更改。

图 1-3. 使用 eBPF 添加内核功能(插图由 Isovalent 的 Vadim Shchekoldin 绘制)

eBPF 程序的高性能

eBPF 程序是一种非常高效的添加检测点的方法。在加载并进行 JIT 编译(JIT-compiled)后(第 3 章中将看到),程序将以原生机器指令在 CPU 上运行。此外,在处理事件时,无需在内核和用户空间之间进行转换(这是一项代价高昂的操作)。

2018 年描述 eXpress Data Path(XDP)的论文10中包含了一些关于 eBPF 在网络中实现性能改进的示例。例如,与常规的 Linux 内核实现相比,在 XDP 中实现路由可以“将性能提高 2.5 倍”,在负载均衡方面,“XDP 提供了比 IPVS 高 4.3 倍的性能提升”。

对于性能追踪和安全可观察性,eBPF 的另一个优势是相关事件可以在内核中被过滤掉,然后再将其发送到用户空间,从而减少了开销。毕竟,过滤特定的网络数据包正是最初 BPF 实现的目的。如今,eBPF 程序可以收集关于系统中各种事件的信息,并使用复杂的、定制的可编程过滤器,只将相关信息的子集发送到用户空间。

云原生环境中的 eBPF

如今,许多组织选择不直接在服务器上执行程序来运行应用程序。相反,许多组织采用云原生方法:容器、如 Kubernetes 或 ECS 的编排器,或无服务器方法,如 Lambda、云函数、Fargate 等。这些方法都使用自动化技术来选择每个工作负载运行的服务器;在无服务器环境中,我们甚至不知道每个工作负载在哪个服务器上运行。

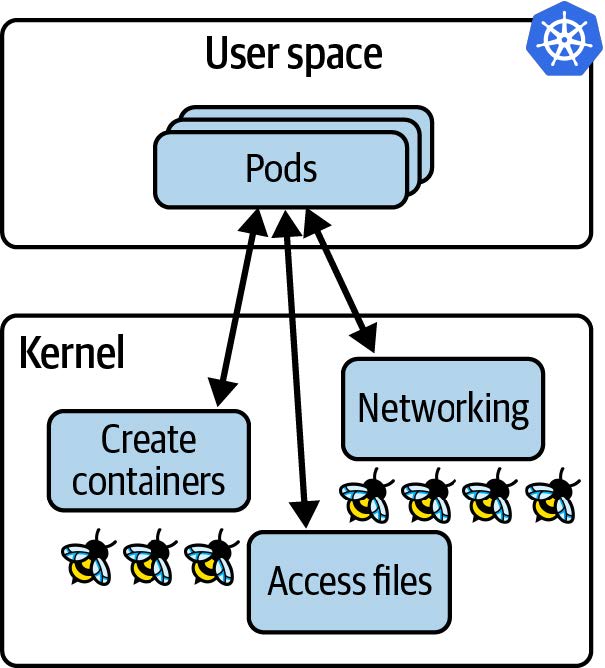

尽管如此,仍然涉及服务器,每台服务器(无论是虚拟机还是裸金属机器)都运行一个内核。如果应用程序在容器中运行,那么它们在同一(虚拟)机器上运行时,共享同一个内核。在 Kubernetes 环境中,这意味着在给定节点上所有 pod 中的所有容器都使用相同的内核。当我们用 eBPF 程序对该内核进行检测时,该节点上所有容器化的工作负载对于这些 eBPF 程序都是可见的,如图 1-4 所示。

图 1-4. 内核中的 eBPF 程序可以看到在 Kubernetes 节点上运行的所有应用程序

对节点上所有进程的可见性,加上动态加载 eBPF 程序的能力,为云原生计算中的 eBPF 工具带来了真正的超能力:

- 我们无需更改应用程序,甚至不需要更改它们的配置,就可以用 eBPF 工具对应用程序进行检测。

- 一旦 eBPF 程序加载到内核并附加到一个事件上,它就可以开始观察预先存在的应用程序进程。

与之相比,Sidecar 模型已被用于向 Kubernetes 应用程序添加日志记录、追踪、安全和服务网格功能等功能。在 Sidecar 方法中,检测工具作为一个容器“注入”到每个应用程序 pod 中。该过程涉及修改定义应用程序 pod 的 YAML,添加 sidecar 容器的定义。这种方法比将检测工具添加到应用程序的源代码中(在 sidecar 方法出现之前,我们不得不这样做;例如,在我们的应用程序中包含一个日志库,并在代码的适当位置调用该库)更方便。然而,Sidecar 方法有一些缺点:

- 为了添加 Sidecar,必须重新启动应用程序 pod。

- 必须修改应用程序的 YAML。这通常是一个自动化过程,但如果出问题,Sidecar 就不会被添加,这意味着 pod 无法被检测。例如,一次部署可能会标注,来指示准入控制器将 Sidecar 的 YAML 添加到本次部署的 pod spec 中。但如果部署没有正确标注,Sidecar 就不会被添加,因此检测工具不具备可见性。

- 当一个 pod 中有多个容器时,它们可能会在不同的时间达到就绪状态,其顺序可能不可预测。注入 Sidecar 可能会显著延长 Pod 的启动时间,甚至更糟糕的是,可能会引发竞争条件或其他不稳定性问题。例如,Open Service Mesh 文档描述了应用程序容器必须能够应对所有流量在 Envoy 代理容器准备就绪之前被丢弃的情况。

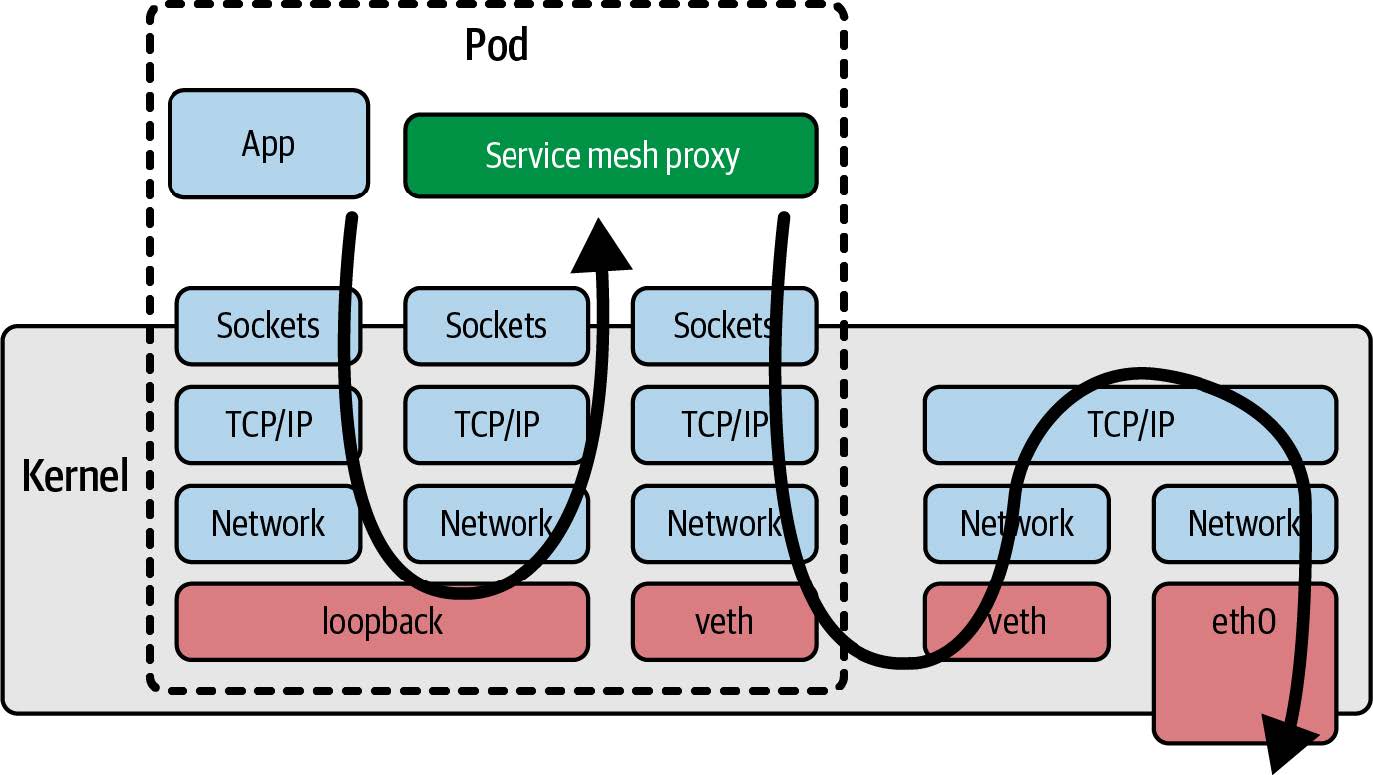

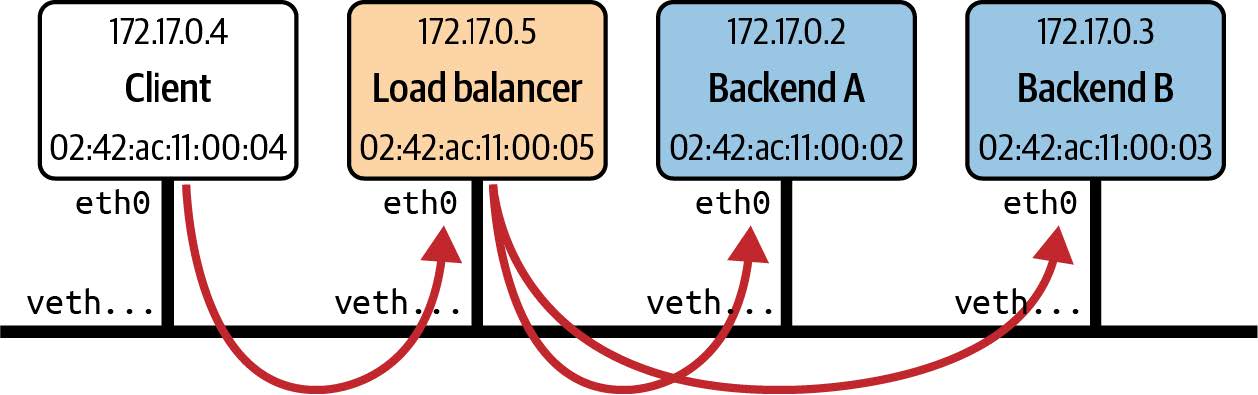

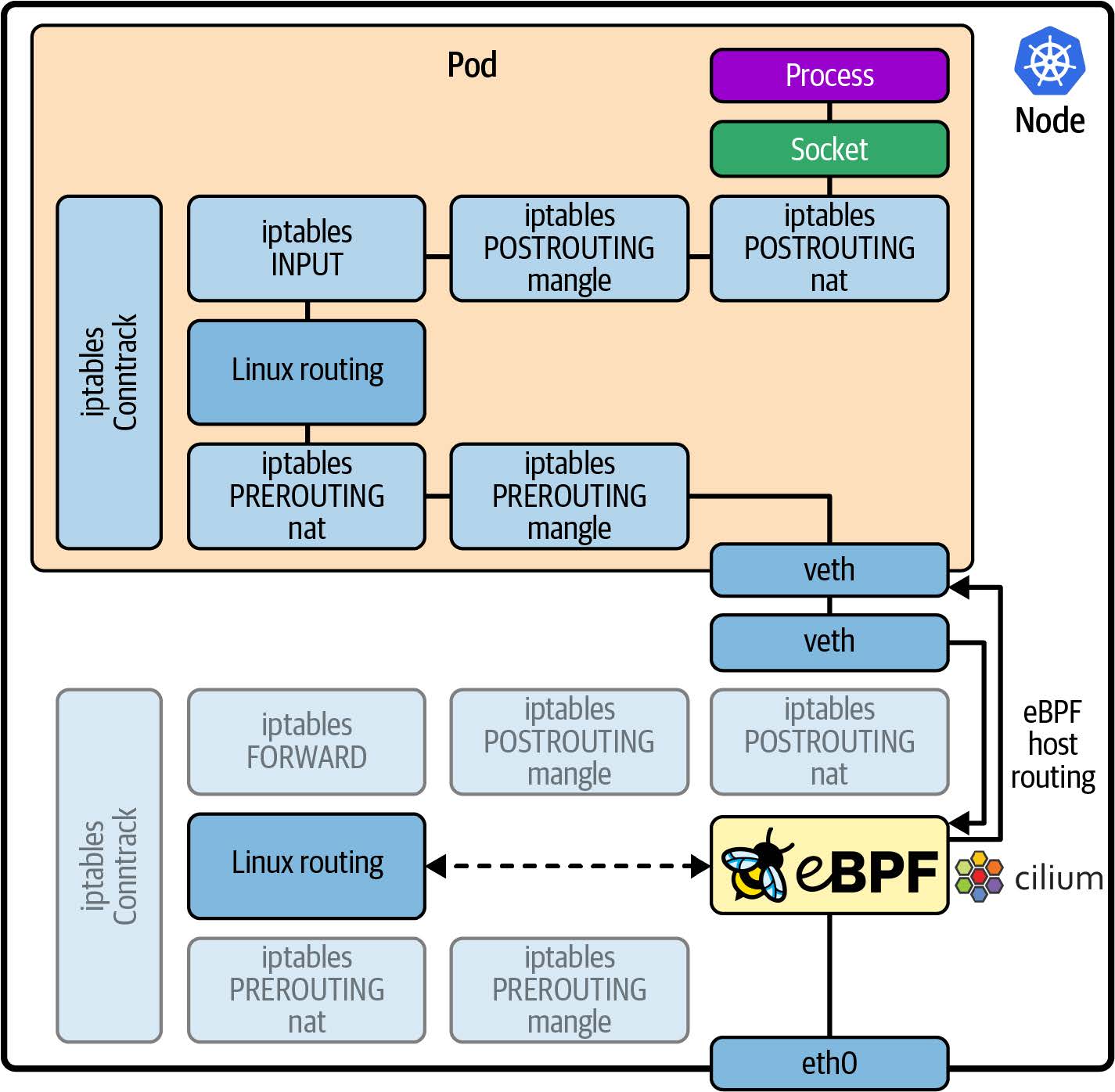

- 当网络功能(如服务网格(service mesh))作为 Sidecar 实现时,这意味着所有进出应用程序容器的流量都必须通过内核中的网络协议栈到达网络代理容器,从而增加了流量的延迟;如图 1-5 所示。我们将在第 9 章讨论用 eBPF 改善网络效率的方法。

图 1-5. 使用服务网格代理 sidecar 容器的网络数据包路径

所有这些问题都是 Sidecar 模型固有的。幸运的是,现在有了 eBPF 作为平台,我们有了一种新的模型可以避免这些问题。此外,由于基于 eBPF 的工具可以观察到(虚拟)机器上发生的一切,恶意行为者很难绕过这些工具。例如,如果攻击者设法在您的主机上部署了一款加密货币挖矿应用程序,他们可能不会将您在应用程序工作负载中使用的 Sidecar 工具部署在他们的挖矿应用程序上。假设您依赖基于 Sidecar 的安全工具来防止应用程序进行意外的网络连接,那么如果 Sidecar 没有被注入,该工具将无法发现挖矿应用程序连接到其挖矿池的行为。相比之下,基于 eBPF 实现的网络安全可以监控主机上的所有流量,因此可以轻松阻止这种加密货币挖矿行为。我们将在第 8 章中重新讨论出于安全原因丢弃网络数据包的能力。

总结

希望本章能让您了解到为何 eBPF 作为一个平台如此强大。它允许我们改变内核的行为,提供构建定制工具或自定义策略的灵活性。基于 eBPF 的工具可以观察到内核中的任何事件,从而观察到(虚拟)机器上运行的所有应用程序,无论它们是否容器化。eBPF 程序还可以动态部署,允许行为随时更改。

到目前为止,我们主要从概念层面讨论了 eBPF。在下一章中,我们将更具体地探索基于 eBPF 的应用程序的组成部分。

Steven McCanne 和 Van Jacobson. “The BSD Packet Filter: A New Architecture for User-level Packet Capture”

这些及其他细节来自 Alexei Starovoitov 在 2015 年 NetDev 演讲中的“BPF – 内核中的虚拟机(BPF – in-kernel virtual machine)”。

内核文档中对 kprobes 工作原理有详细的描述。

这一精彩事实来自 Daniel Borkmann 在 2020 年 KubeCon 演讲中的“eBPF 和 Kubernetes: 用于扩展微服务的小助手(eBPF and Kubernetes: Little Helper Minions for Scaling Microservices)”。

有关指令限制和“复杂性限制”的更多细节,请参见 https://oreil.ly/0iVer。

摘自 Liz Rice 的 “什么是 eBPF?(What Is eBPF?)”。版权 © 2022 O’Reilly Media。经许可使用。

“Linux 5.12 的代码量约 2880 万行”。Phoronix,2021 年 3 月。

Jiang Y, Adams B, German DM. 2013. “我的补丁会被接受吗?会有多快?”(2013)。根据这篇研究论文,33%的补丁被接受,大多数补丁需要三到六个月的时间。

庆幸的是,现有功能的安全补丁会更快地发布。

Høiland-Jørgensen T, Brouer JD, Borkmann D 等人 “eXpress 数据路径:操作系统内核中的快速可编程数据包处理”。第 14 届国际网络实验与技术会议(CoNEXT ’18)论文集。计算机协会;2018:54–66。

第 2 章 eBPF 的 Hello World

在上一章中,我讨论了 eBPF 的强大之处,但如果您尚未具体理解运行 eBPF 程序的真正含义,那也没有关系。在本章中,我将通过一个简单的“Hello World”示例,让您更好地了解它。

正如您在阅读本书时会了解到的,有几种不同的库和框架可用于编写 eBPF 应用程序。作为热身,我将向您展示从编程角度来看可能最易于理解的方法:使用BCC Python 框架。这提供了一种非常简单的方式来编写基本的 eBPF 程序。出于我将在第 5 章中介绍的原因,对于分发给其他用户的生产应用程序,这不一定是我推荐的方法,但对于初学者来说非常棒。

正如您在阅读本书时将了解到的,编写 eBPF 应用程序有多种不同的库和框架。作为热身,我将向您展示从编程角度来看最容易上手的方法:BCC Python 框架。这提供了一种非常简单的方法来编写基本的 eBPF 程序。出于我将在第 5 章中介绍的原因,对于分发给其他用户的生产应用程序,这不一定是我推荐的方法,但它非常适合于入门。

note

如果您想亲自尝试这些代码,可以在 https:// github.com/lizrice/learning-ebpf 的 chapter2 目录中找到。

您可以在https://github.com/iovisor/bcc 找到 BCC 项目,并在 https://github.com/iovisor/bcc/blob/master/INSTALL.md 上找到安装 BCC 的说明。

BCC 的 “Hello World”

下面是 hello.py 的全部源代码,这是一个使用 BCC 的 Python 库编写的 eBPF “Hello World”应用程序1:

#!/usr/bin/python3

from bcc import BPF

program = r"""

int hello(void *ctx) {

bpf_trace_printk("Hello World!");

return 0;

}

"""

b = BPF(text=program)

syscall = b.get_syscall_fnname("execve")

b.attach_kprobe(event=syscall, fn_name="hello")

b.trace_print()

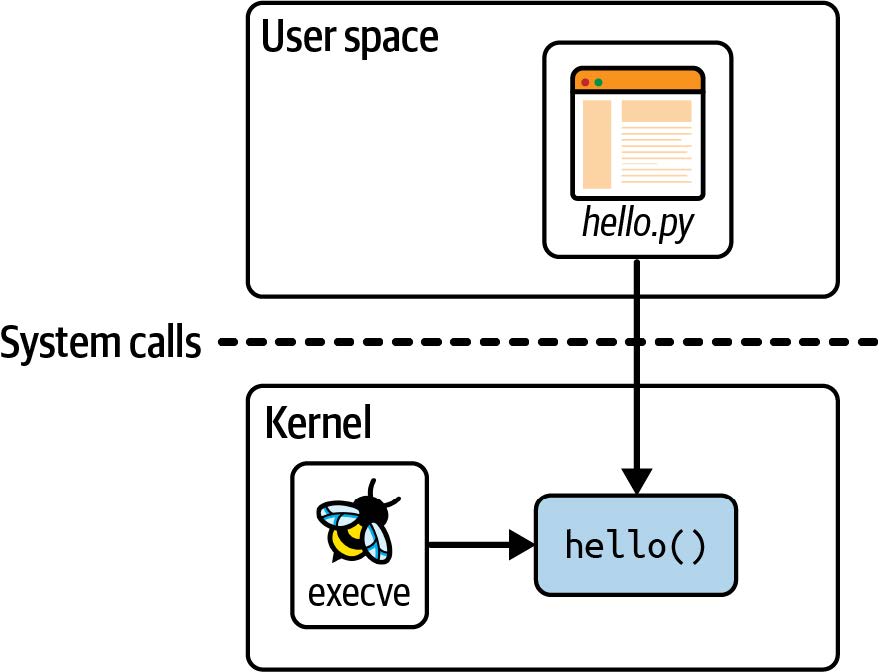

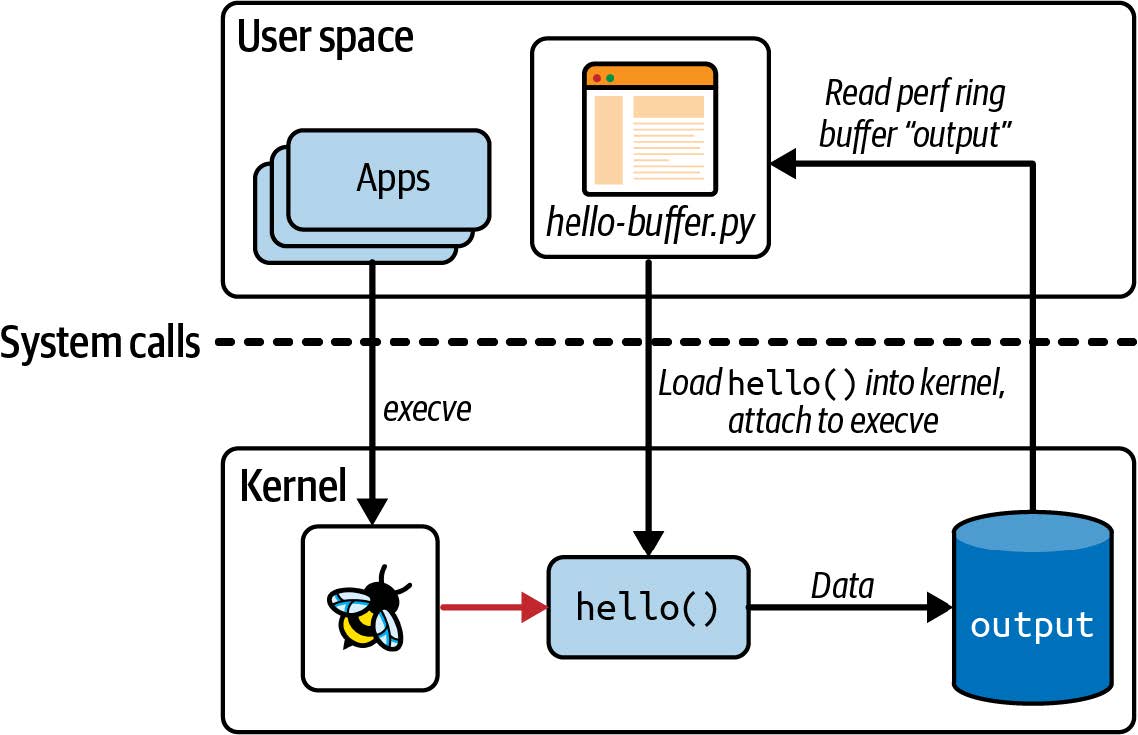

这段代码由两部分组成:将在内核中运行的 eBPF 程序,和将 eBPF 程序加载到内核并读取其生成的跟踪信息的一些用户空间代码。如图 2-1 所示,hello.py 是该应用程序的用户空间部分,而 hello() 是在内核中运行的 eBPF 程序。

图 2-1. “Hello World” 的用户空间和内核组件

让我们深入了解源代码的每一行,以便更好地理解它。

第一行表明这是 Python 代码,可以运行它的程序是 Python 解释器 (/usr/bin/python)。

eBPF 程序本身是用 C 代码编写的,具体如下:

int hello(void *ctx) {

bpf_trace_printk("Hello World!");

return 0;

}

这个 eBPF 程序所做的只是使用一个辅助函数 bpf_trace_printk() 来写一条消息。辅助函数是“扩展(extended)”BPF 与其“经典(classic)”前身的另一个区别特征。它们是一组 eBPF 程序可以调用与系统交互的函数;我将在第 5 章进一步讨论它们。目前,您可以将其视为打印一行文本。

整个 eBPF 程序在 Python 代码中被定义为一个名为 program 的字符串。该 C 程序需要先进行编译才能执行,但 BCC 会为您处理好。 (您将在下一章中看到如何自己编译 eBPF 程序)您所需要做的就是在创建 BPF 对象时将此字符串作为参数传递,如下行所示:

整个 eBPF 程序在 Python 代码中定义为一个名为 program 的字符串。这个 C 程序需要在执行之前进行编译,但 BCC 为您处理了这一点。(您将在下一章中看到如何自己编译 eBPF 程序。)您所需要做的就是在创建 BPF 对象时将此字符串作为参数传入,如下所示:

b = BPF(text=program)

eBPF 程序需要附加到一个事件上,在这个例子中,我选择附加到系统调用 execve 上,这是用于执行程序的系统调用。无论何时,在这台机器上启动新程序,都会调用 execve(),从而触发 eBPF 程序。虽然“execve()”名称是 Linux 中的标准接口,但实现它的内核函数的名称取决于芯片架构,但 BCC 提供了一种方便的方法来查找我们运行的机器的函数名称:

syscall = b.get_syscall_fnname("execve")

现在,syscall代表我要使用kprobe附加到的内核函数的名称(第 1 章已经介绍了kprobe的概念)2。您可以像这样将hello函数附加到该事件上:

b.attach_kprobe(event=syscall, fn_name="hello")

此时,eBPF 程序被加载到内核中并附加到一个事件上,因此只要机器上启动新的可执行文件时,该程序就会被触发。 Python 代码中剩下要做的就是读取内核输出的跟踪信息并将其输出到屏幕上:

b.trace_print()

这个 trace_print() 函数将无限循环(直到您停止程序,例如通过 Ctrl+C),显示所有跟踪信息。

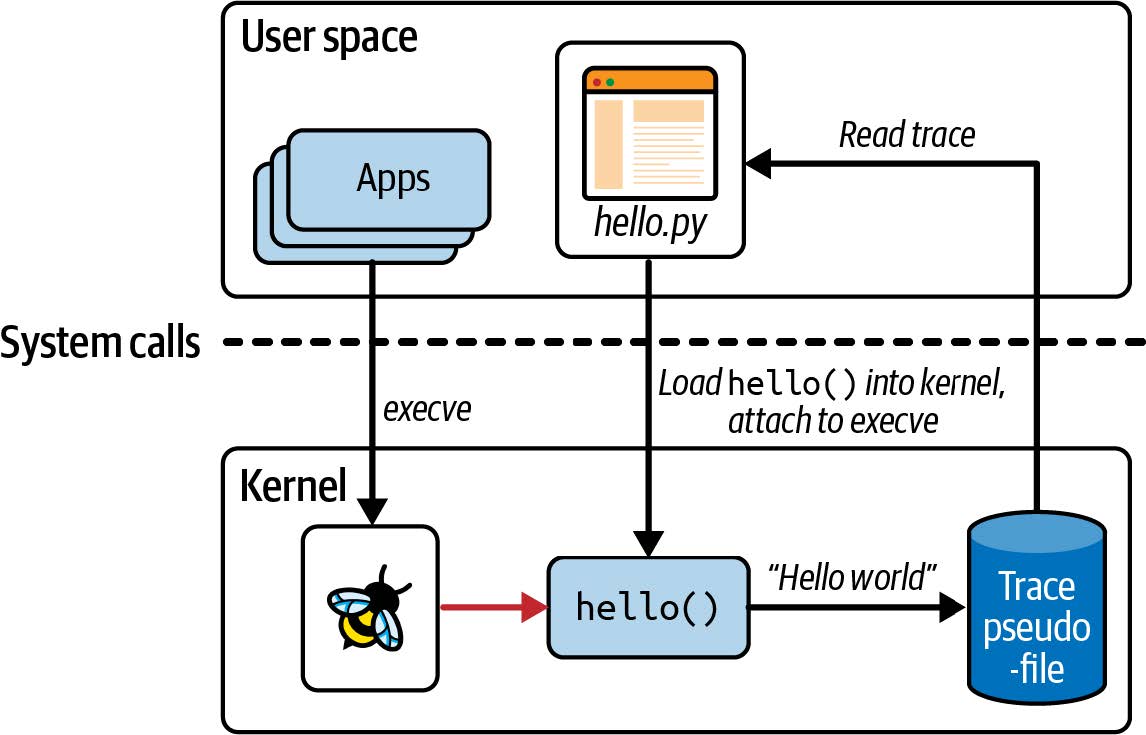

图 2-2 说明了这段代码。Python 程序编译 C 代码,将其加载到内核,并将其附加到 execve 系统调用的 kprobe 上。无论何时在这台(虚拟)机器上调用 execve(),都会触发 eBPF 程序 hello() ,后者会将一行跟踪信息写入一个特定的伪文件中。(稍后在本章中我会介绍该伪文件的位置。)Python 程序从伪文件中读取跟踪消息并显示给用户。

图 2-2. "Hello World" 的操作

运行 "Hello World"

运行这个程序,根据您使用的(虚拟)机器上发生的情况,您可能会立即看到生成的跟踪信息,因为其他进程可能正在执行带有 execve 系统调用的程序3。如果没有看到任何输出,请打开第二个终端并执行您喜欢的任何命令4,您将看到 “Hello World” 生成的相应跟踪信息:

$ hello.py

b' bash-5412 [001] .... 90432.904952: 0: bpf_trace_printk: Hello World'

note

由于 eBPF 非常强大,因此需要特殊权限才能使用它。权限会自动分配给 root 用户,因此最简单的方法是以 root 身份运行 eBPF 程序,或使用 sudo 命令。为清晰起见,本书中的示例命令不会包含 sudo,但如果您遇到“Operation not permitted”错误,首先要检查的是您是否以非特权用户身份尝试运行 eBPF 程序。

CAP_BPF 是在内核版本 5.8 中引入的,它赋予了一些执行 eBPF 操作(如创建某些类型的映射)的足够权限。然而,您可能还需要额外的权限:

- 加载跟踪程序需要

CAP_PERFMON和CAP_BPF。 - 加载网络程序需要

CAP_NET_ADMIN和CAP_BPF。

关于这方面的详细信息,请参阅 Milan Landaverde 的博客文章 “CAP_BPF 简介(Introduction to CAP_BPF)”。

一旦 eBPF 程序 hello 加载并附加到一个事件,就可以被预先存在的进程生成的事件触发。这应该进一步巩固了您在第 1 章中学到的几点::

- eBPF 程序可用于动态更改系统行为。无需重新启动机器或重启现有进程。eBPF 代码一旦附加到事件上,就会立即生效。

- 无需更改其他应用程序,即可使它们对 eBPF 可见。无论您在该机器上的哪个终端访问,如果您在其中运行可执行文件,它将使用

execve()系统调用,而如果您将 hello 程序附加到该系统调用,它将被触发生成跟踪输出。同样,如果您有一个运行可执行文件的脚本,它也会触发 eBPF 程序 hello。您无需更改终端的 shell、脚本或正在运行的可执行文件。

跟踪输出不仅显示了 "Hello World" 字符串,还显示了一些关于触发 eBPF 程序 hello 运行的事件的附加上下文信息。在本节开头显示的示例输出中,执行 execve 系统调用的进程 ID 为 5412,并且它正在运行 bash 命令。对于跟踪消息,这些上下文信息作为内核跟踪基础结构的一部分被添加(这并不是 eBPF 所特有的),但正如您将在本章稍后看到的,也可以在 eBPF 程序中检索到这样的上下文信息。

您可能会想知道 Python 代码是如何知道从哪里读取跟踪输出的。答案并不复杂——内核中的 bpf_trace_printk() 辅助函数总是将输出发送到同一个预定义的伪文件位置:/sys/kernel/debug/tracing/trace_pipe。您可以通过使用 cat 查看其内容来确认这一点;您需要 root 权限才能访问它。

对于简单的 “Hello World” 示例或基本的调试目的来说,一个单一的跟踪管道(trace pipe)位置是可以接受的,但也非常有限。输出格式几乎没有灵活性,并且只支持字符串输出,因此对于传递结构化信息并不是特别有用。或许最重要的是,整个(虚拟)机器上只有这样一个位置。如果同时运行多个 eBPF 程序,它们都会将跟踪输出写入同一个跟踪管道,这对操作人员来说可能会非常混乱。

有一种获取 eBPF 程序信息的更好方法:使用 eBPF 映射(eBPF Map)。

BPF 映射(eBPF Maps)

*映射(map)*是一种数据结构,可以从 eBPF 程序和用户空间访问。映射是将扩展 BPF 与其经典前身区分开来的一个重要特性。(您可能会认为这意味着它们通常被称为 “eBPF 映射(eBPF maps)”。但实际上,您会经常看到 “BPF 映射(BPF maps)”。通常,这两个术语可以互换使用。)

映射可以用于在多个 eBPF 程序之间共享数据,或在用户空间应用程序与内核中运行的 eBPF 代码之间进行通信。典型的用途包括:

- 用户空间写入配置信息,以便 eBPF 程序检索

- eBPF 程序存储状态,供另一个 eBPF 程序(或未来运行的同一程序)检索

- eBPF 程序将结果或指标写入映射,以供用户空间应用程序检索并展示结果

在 Linux 的 uapi/linux/bpf.h 文件中定义了各种类型的 BPF 映射,并且内核文档中也有一些关于它们的信息。一般来说,它们都是键-值存储,在本章中,您将看到哈希表(hash tables)、perf 和环形缓冲区(ring buffers)、eBPF 程序数组(arrays of eBPF programs)等映射的示例。

有些映射类型被定义为数组,其键类型始终为 4 字节索引;其他映射是哈希表,可以使用任意数据类型作为键。

有些映射类型针对特定类型的操作进行了优化,例如先进先出队列、后进先出栈、最近最少使用的数据存储、最长前缀匹配和布隆过滤器(一种概率数据结构,旨在提供非常快速的元素存在性检查)。

有些 eBPF 映射类型保存特定类型对象的信息。例如,sockmaps 和 devmaps 保存有关套接字和网络设备的信息,并被网络相关的 eBPF 程序用来重定向流量。程序数组映射(program array map)存储一组索引的 eBPF 程序(正如您将在本章稍后看到的),这用于实现尾调用(tail calls),即一个程序可以调用另一个程序。甚至还有一种 map-of-maps 类型,支持存储关于映射的信息。

有些映射类型有 per-CPU 变体,即每个 CPU 核心对于该映射都有各自的版本,并且内核使用不同的内存块来存储它们。这可能会让您担心非 per-CPU 映射的并发问题,即多个 CPU 核心可能会同时访问同一个映射。内核版本 5.1 中添加了对(某些)映射的自旋锁支持,我们将在第 5 章中回到这个话题。

下一个示例(GitHub 仓库中的 chapter2/hello-map.py)展示了一些使用哈希表映射(hash table map)的基本操作。它还演示了 BCC 提供的一些方便的抽象,使映射的使用变得非常容易。

哈希表映射(Hash Table Map)

像本章前面的示例一样,这个 eBPF 程序将附加到 execve 系统调用的入口处的 kprobe。它将用键值对填充哈希表,其中键是用户 ID,值是该用户 ID 下运行的进程调用 execve 的次数。实际上,这个示例将显示不同用户运行程序的次数。

首先,让我们看一下 eBPF 程序本身的 C 代码:

BPF_HASH(counter_table); // 1

int hello(void *ctx) {

u64 uid;

u64 counter = 0;

u64 *p;

uid = bpf_get_current_uid_gid() & 0xFFFFFFFF; // 2

p = counter_table.lookup(&uid); // 3

if (p != 0) { // 4

counter = *p;

}

counter++; // 5

counter_table.update(&uid, &counter); // 6

return 0;

}

BPF_HASH()是一个 BCC 宏,用于定义一个哈希表映射。bpf_get_current_uid_gid()是一个辅助函数,用于获取触发此 kprobe 事件的进程的用户 ID。用户 ID 保存在返回的 64 位值的低 32 位中。(高 32 位保存组 ID,但在这里,该部分被屏蔽掉。)- 在哈希表中查找与用户 ID 匹配的键条目。它返回指向哈希表中对应值的指针。

- 如果该用户 ID 有条目,将

counter变量设置为哈希表中的当前值(由p指向)。如果哈希表中没有该用户 ID 的条目,指针将为0,counter值将保持为0。 - 无论当前的

counter值是多少,它都会增加一。 - 用该用户 ID 的新

counter值更新哈希表。

仔细看一下访问哈希表的代码行:

p = counter_table.lookup(&uid);

以及后面的:

counter_table.update(&uid, &counter);

如果您在想“这不是标准的 C 代码!”,那么没错,您绝对是正确的。C 语言不支持在结构体上定义这样的方法5。这是一个很好的例子,说明了 BCC 的 C 版本实际上是一种类 C 语言,BCC 在将代码发送到编译器之前会对其进行重写。BCC 提供了一些便捷的快捷方式和宏,将其转换为“标准”的 C 代码。

就像前面的例子一样,C 代码被定义为一个名为 program 的字符串。该程序被编译、加载到内核,并附加到 execve 的 kprobe,方式与之前的 “Hello World” 示例完全相同:

b = BPF(text=program)

syscall = b.get_syscall_fnname("execve")

b.attach_kprobe(event=syscall, fn_name="hello")

这次在 Python 端需要做更多的工作来读取哈希表中的信息:

while True: # 1

sleep(2)

s = ""

for k,v in b["counter_table"].items(): # 2

s += f"ID {k.value}: {v.value}\t"

print(s)

- 这段代码会无限循环,每两秒钟查看一次输出并显示。

- BCC 自动创建一个 Python 对象来表示哈希表。该代码循环遍历所有值并将其打印到屏幕上。

当您运行此示例时,您将需要第二个终端窗口,您可以在其中运行一些命令。这是我获得的一些示例输出,在右侧用我在另一个终端中运行的命令进行了注释:

运行此示例时,您需要第二个终端窗口,来运行一些命令。以下是我获得的示例输出,在右侧注释了我在另一个终端中运行的命令:

Terminal 1 Terminal 2

$ ./hello-map.py

[blank line(s) until I run something]

ID 501: 1 ls

ID 501: 1

ID 501: 2 ls

ID 501: 3 ID 0: 1 sudo ls

ID 501: 4 ID 0: 1 ls

ID 501: 4 ID 0: 1

ID 501: 5 ID 0: 2 sudo ls

这个示例每两秒生成一行输出,无论是否发生任何事情。在该输出的末尾,哈希表包含两个条目:

key=501, value=5key=0, value=2

在第二个终端中,我的用户 ID 为 501。运行 ls 命令时,该用户 ID 下的 execve 计数器会增加。当我运行 sudo ls 时,会导致两次 execve 调用:一次是以用户 ID 501 执行 sudo;另一次是以 root 的用户 ID 0 执行 ls。

在这个例子中,我使用了哈希表来将数据从 eBPF 程序传递到用户空间。(我也可以使用数组类型的 Map,因为键是整数;而哈希表允许您使用任意类型作为键)当数据自然地以键值对的形式存在时,哈希表非常方便,但用户空间的代码必须定期轮询表来获取数据。Linux 内核已经支持了 perf 子系统,用于从内核向用户空间发送数据,而且 eBPF 还包括对 perf 缓冲区(perf buffers)和其后继者 BPF 环形缓冲区(BPF ring buffers)的支持。让我们来看一下。

Perf 和环形缓冲区映射(Ring Buffer Maps)

在本节中,我将描述一个稍微复杂一些的 “Hello World” 示例,该示例使用 BCC 的 BPF_PERF_OUTPUT 功能,将数据写入到一个 perf 环形缓冲区映射(perf ring buffer map)中。

note

如果您使用的是 5.8 或更高版本的内核,现在通常更推荐使用 “BPF 环形缓冲区(BPF ring buffers)” 这一新构造,而不是 BPF perf 缓冲区(BPF perf buffers)。Andrii Nakryiko 在他的 BPF 环形缓冲区(BPF ring buffers)博客文章中讨论了它们之间的区别。您将在第 4 章中看到 BCC 的 BPF_RINGBUF_OUTPUT 的示例。

环形缓冲区并不是 eBPF 独有的,但我会解释一下,以防您之前没有接触过。您可以将环形缓冲区想象为一个在逻辑上组织成环形的内存片段,具有独立的“写”指针和“读”指针。任意长度的数据写入写指针所在的位置,数据的长度信息包含在该数据的头部中。写指针移动到该数据的末尾,为下一个写操作做好准备。

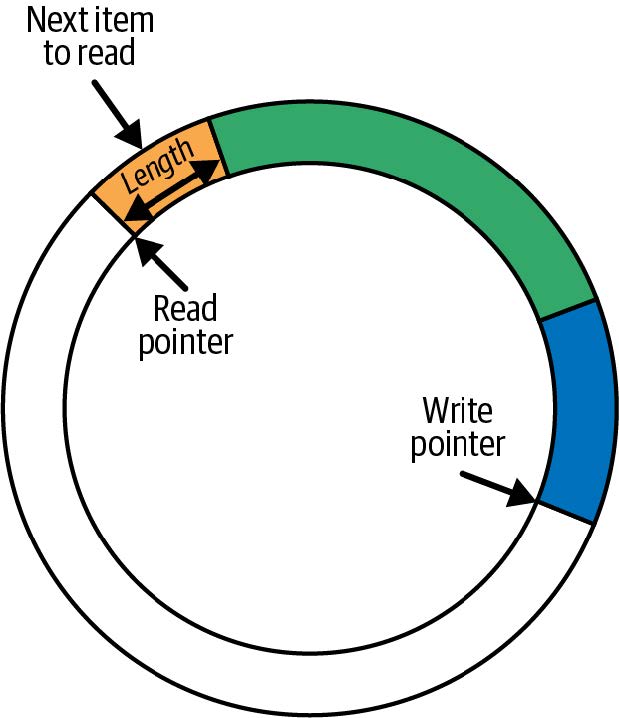

同样,对于读操作,数据从读指针所在的位置读取,使用头部来确定要读取的数据量。读指针沿着与写指针相同的方向移动,指向下一个可用的数据片段。如图 2-3 所示,显示了一个具有三个不同长度可读项的环形缓冲区。

如果读指针追上了写指针,意味着没有数据可读。如果写操作会使写指针超过读指针,数据将不会被写入,并且丢弃计数器(drop counter)会增加。读操作包括丢弃计数器,以指示自上次成功读取以来是否有数据丢失。

如果读写操作完全以相同的速率恒定地进行,并且总是包含相同的数据量,理论上您可以使用一个刚好容纳这些数据大小的环形缓冲区。在大多数应用中,读取、写入之间或两者之间的时间会有所不同,因此需要调整缓冲区大小以应对这些变化。

您可以在 Learning eBPF GitHub 仓库的chapter2/hello-buffer.py中找到此示例的源代码。与本章早期展示的第一个“Hello World”示例一样,该版本在每次使用execve()系统调用时都会将字符串“Hello World”写入屏幕。它还会查找每个调用 execve()的进程 ID 和命令名称,以便您能够获得类似于第一个示例的输出。这为我提供了展示几个 BPF 辅助函数的机会。

您可以在 Learning eBPF GitHub 仓库的 chapter2/hello-buffer.py 中找到此示例的源代码。与本章开头看到的第一个 “Hello World” 示例一样,该版本将在每次使用 execve() 系统调用时将字符串 "Hello World" 写到屏幕上。此外,它还会查找每个调用 execve() 的进程 ID 和命令名称,以便您能够获得类似于第一个示例的输出。这给了我展示更多 BPF 辅助函数的机会。

这是将加载到内核的 eBPF 程序:

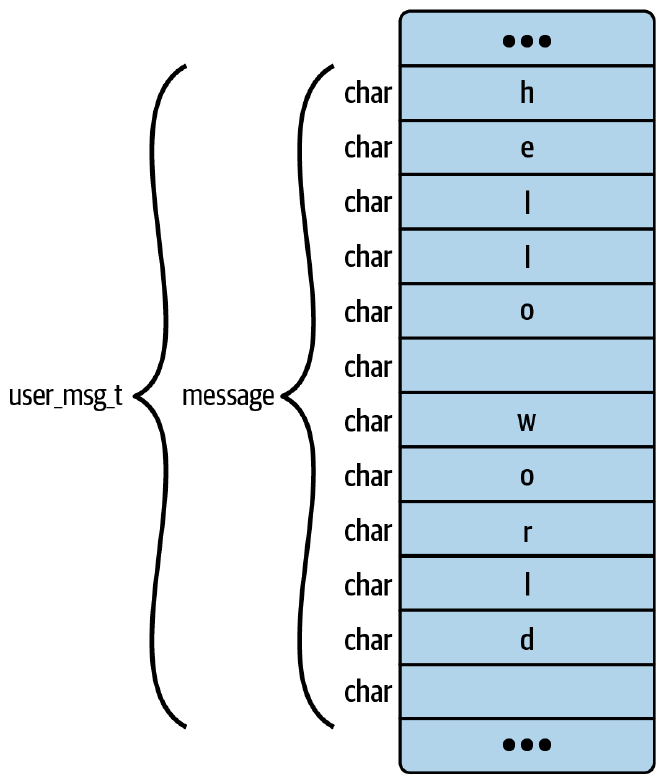

BPF_PERF_OUTPUT(output); // 1

struct data_t { // 2

int pid;

int uid;

char command[16];

char message[12];

};

int hello(void *ctx) {

struct data_t data = {}; // 3

char message[12] = "Hello World";

data.pid = bpf_get_current_pid_tgid() >> 32; // 4

data.uid = bpf_get_current_uid_gid() & 0xFFFFFFFF; // 5

bpf_get_current_comm(&data.command, sizeof(data.command)); // 6

bpf_probe_read_kernel(&data.message, sizeof(data.message), message); // 7

output.perf_submit(ctx, &data, sizeof(data)); // 8

return 0;

}

- BCC 定义了用于创建映射的宏

BPF_PERF_OUTPUT,该映射用于将消息从内核传递到用户空间。我将这个映射命名为output。 - 每次运行

hello()时,代码都会写入一个结构体的数据。以下是该结构体的定义,包含进程 ID、当前运行命令的名称和一条文本消息。 data是一个局部变量,保存要提交的数据结构,而message保存"Hello World"字符串。bpf_get_current_pid_tgid()是一个辅助函数,用于获取触发此 eBPF 程序运行的进程 ID。它返回一个 64 位值,其中进程 ID 位于高 32 位6。bpf_get_current_uid_gid()是您在前一个示例中看到的用于获取用户 ID 的辅助函数。- 同样,

bpf_get_current_comm()是一个辅助函数,用于获取执行execve系统调用的进程中正在运行的可执行文件(或“命令”)的名称。这是一个字符串,而不是像进程和用户 ID 那样的数值,在 C 语言中您不能简单地使用=赋值字符串。您必须将字符串应写入的字段的地址&data.command作为参数传递给辅助函数。 - 对于这个示例,每次的消息都是

"Hello World"。bpf_probe_read_kernel()将其复制到数据结构体中的正确位置。 - 此时,数据结构体已经填充了进程 ID、命令名称和消息。调用

output.perf_submit()将这些数据放入映射中。

就像第一个“Hello World”示例一样,这个 C 程序被分配给 Python 代码中的一个名为 program 的字符串。接下来是其余的 Python 代码:

b = BPF(text=program) # 1

syscall = b.get_syscall_fnname("execve")

b.attach_kprobe(event=syscall, fn_name="hello")

def print_event(cpu, data, size): # 2

data = b["output"].event(data)

print(f"{data.pid} {data.uid} {data.command.decode()} {data.message.decode()}")

b["output"].open_perf_buffer(print_event) # 3

while True: # 4

b.perf_buffer_poll()

- 编译 C 代码,将其加载到内核中,并附加到

syscall事件,与之前看到的“Hello World”版本相同。 print_event是一个回调函数,它将在屏幕上输出一行数据。BCC 进行了一些繁重的工作,以便可以简单地通过b["output"]引用映射,并使用b["output"].event()从中获取数据。b["output"].open_perf_buffer()打开 perf 环形缓冲区。该函数将print_event作为参数,以定义在缓冲区中有数据可读取时使用的回调函数。- 现在,该程序将无限循环7,轮询 perf 环形缓冲区。如果有任何可用数据,

print_event将被调用。

运行此代码,我们会得到类似于原来“Hello World”的输出:

$ sudo ./hello-buffer.py

11654 node Hello World

11655 sh Hello World

...

与以前一样,您可能需要打开第二个终端连接到相同的(虚拟)机器,并运行一些命令来触发输出。

与原来“Hello World”示例的最大区别在于,它不再使用一个中央跟踪管道(central trace pipe),而是通过一个名为 output 的环形缓冲区映射传递数据,该映射是由此程序创建供其自身使用的,如图 2-4 所示。

图 2-4.使用 perf 环形缓冲器从内核向用户空间传递数据

您可以使用 cat /sys/kernel/debug/tracing/trace_pipe 来验证信息没有传递到跟踪管道(trace pipe)。

除了展示环缓冲区映射的使用外,此示例还展示了一些 eBPF 辅助函数,用于检索触发 eBPF 程序运行的事件的上下文信息。这里您已经看到辅助函数获取用户 ID、进程 ID 和当前命令的名称。如第七章所述,程序类型和触发事件的类型决定了可用的上下文信息集合以及可用于检索信息的有效辅助函数集合。

上下文信息的可用性使得 eBPF 代码在可观测性方面极具价值。每当事件发生时,eBPF 程序不仅可以报告事件发生的事实,还可以报告触发事件的相关信息。由于所有这些信息都可以在内核内收集,而无需同步上下文切换到用户空间,因此性能也非常高。

在本书中,您将看到更多使用 eBPF 辅助函数收集其他上下文数据的示例,以及一些 eBPF 程序更改上下文数据甚至阻止事件发生的示例。

函数调用

您已经看到 eBPF 程序可以调用内核提供的辅助函数,但如果您想将编写的代码分割成多个函数呢?在软件开发中,通常被认为是良好的实践8是将常见代码提取到一个函数中,然后从多个地方调用它,而不是一遍又一遍地重复相同的代码行。但在早期,eBPF 程序不允许调用辅助函数以外的其他函数。为了解决这个问题,程序员通常会指示编译器“始终内联(always inline)”他们的函数,如下所示:

static __always_inline void my_function(void *ctx, int val)

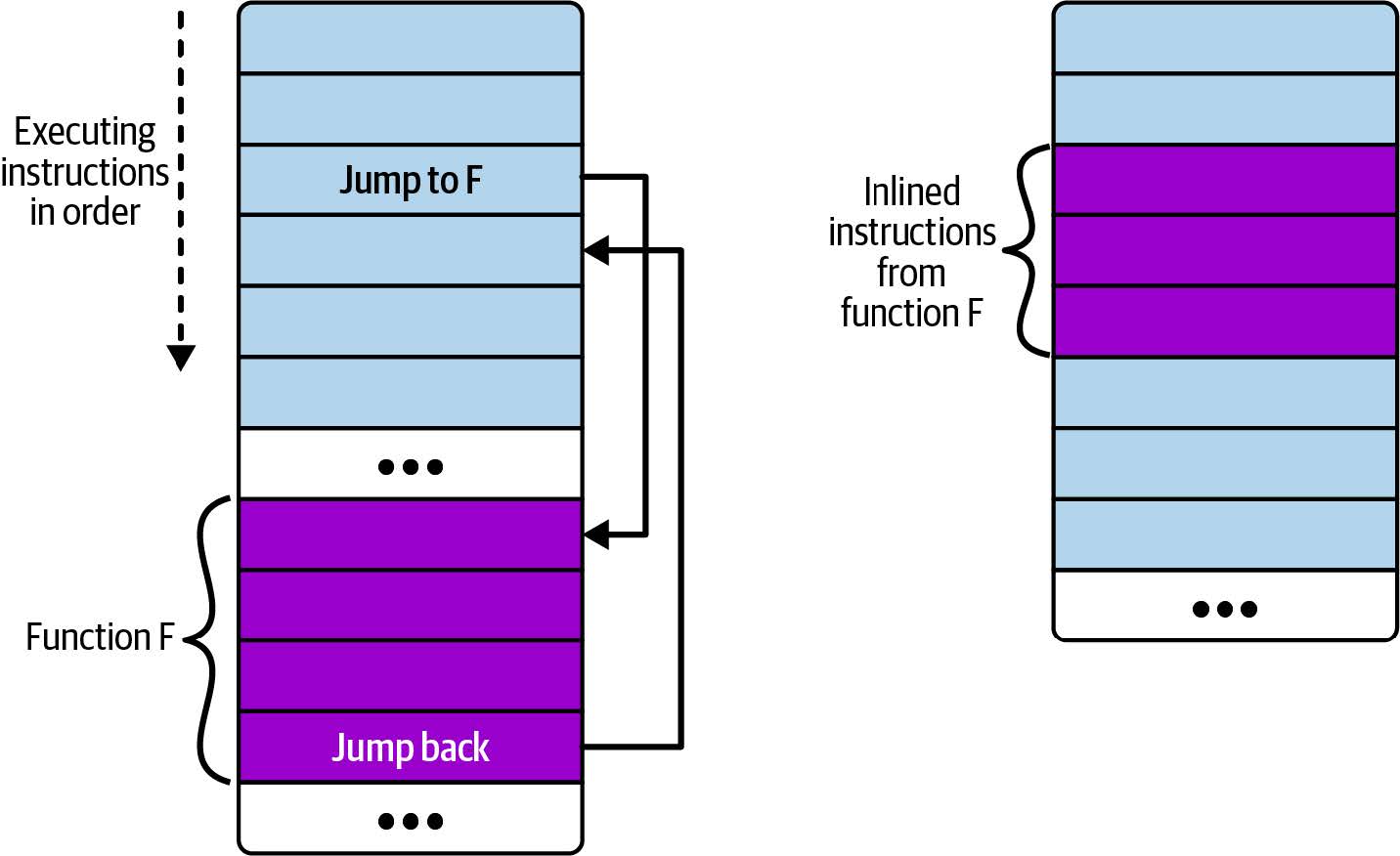

通常,源代码中的一个函数会导致编译器发出一个跳转指令,这会使执行跳转到构成被调用函数的指令集合(然后在该函数完成时跳转回来)。您可以在图 2-5 的左侧看到这种情况的示意图。右侧显示了内联函数时的情况:没有跳转指令;相反,在调用函数内直接包含函数的指令副本。

图 2-5. 非内联函数和内联函数的指令布局

如果函数从多个地方调用,那么在编译后的可执行文件中将会有多个该函数的指令副本。(有时编译器可能选择内联某个函数以进行优化,这也是为什么您可能无法将 kprobe 附加到某些内核函数的原因之一。我将在第 7 章中再次讨论这个问题。)

如果从多个地方调用该函数,这会导致在编译后的可执行文件中包含多个该函数指令的副本。(有时编译器可能会出于优化目的,选择内联一个函数。这也是为什么您可能无法附加 kprobe 到某些内核函数的原因之一。在第七章中,我会再提到这一点。)

从 Linux 内核 4.16 和 LLVM 6.0 开始,解除了需要将函数内联的限制,以便 eBPF 程序员可以更自然地编写函数调用。然而,这个名为“BPF to BPF function calls”或“BPF 子程序”的特性目前不受 BCC 框架支持,所以我们将在下一章中回顾它。(当然,如果函数是内联的,您仍然可以继续在 BCC 中使用函数。)

从 Linux 内核 4.16 和 LLVM 6.0 开始,解除了要求函数内联的限制,因此 eBPF 程序员可以更自然地编写函数调用。然而,目前 BCC 框架不支持“BPF 到 BPF 函数调用(BPF to BPF function calls)”或“BPF 子程序(BPF subprograms)”这一特性,因此我们将在下一章中再讨论它。(当然,如果函数是内联的,您仍然可以在 BCC 中继续使用它们。)

在 eBPF 中,还有另一种机制可以将复杂功能分解成更小的部分:尾调用(tail calls)。

尾调用(Tail Calls)

正如 ebpf.io 所描述的那样,“尾调用可以调用并执行另一个 eBPF 程序,并替换执行上下文,类似于 execve() 系统调用对常规进程的操作。”换句话说,尾调用完成后执行不会返回给调用者。

note

尾调用绝不仅仅限于 eBPF 编程。尾调用的总体动机是避免在函数递归调用时一遍又一遍地增加栈帧,这最终可能导致栈溢出错误。如果您可以安排代码在最后调用递归函数,那么调用函数关联的栈帧实际上没有任何作用了。(译者注:在一个函数的最后一条语句调用递归函数,那么当前这个函数的栈帧也就没有什么用了,信息都已经传递给新的函数了。)尾调用允许调用一系列函数而不增加栈。这在 eBPF 中特别有用,因为栈被限制为 512 字节。

尾调用使用 bpf_tail_call() 辅助函数来完成,其签名如下:

long bpf_tail_call(void *ctx, struct bpf_map *prog_array_map, u32 index)

该函数的三个参数的含义如下:

ctx允许从调用的 eBPF 程序传递上下文到被调用程序。prog_array_map是一个BPF_MAP_TYPE_PROG_ARRAY类型的 eBPF 映射,用于保存一组文件描述符,这些描述符用于标识 eBPF 程序。index表示应调用该组 eBPF 程序中的哪个程序。。

这个辅助函数有点不寻常,因为如果它成功执行,将永远不会返回。当前运行的 eBPF 程序的栈会被被调用的程序替换。如果指定的程序不存在于映射中,则可能会失败。在这种情况下,调用程序会继续执行。

用户空间代码必须(像往常一样)将所有 eBPF 程序加载到内核中,并设置程序数组映射(program array map)。

让我们看一个使用 BCC 编写的简单 Python 示例;您可以在GitHub 仓库中的 chapter2/hello-tail.py 找到代码。主 eBPF 程序附加到所有系统调用公共入口点的跟踪点(tracepoint)上。这个程序使用尾调用来跟踪特定系统调用操作码的消息。如果给定操作码没有尾调用,程序会跟踪一个通用消息。

如果您使用 BCC 框架,可以通过稍微简化的形式进行尾调用:

prog_array_map.call(ctx, index)

在将代码传递到编译步骤之前,BCC 会将这一行重写为:

bpf_tail_call(ctx, prog_array_map, index)

以下是 eBPF 程序及其尾调用的源代码:

BPF_PROG_ARRAY(syscall, 300); // 1

int hello(struct bpf_raw_tracepoint_args *ctx) { // 2

int opcode = ctx->args[1]; // 3

syscall.call(ctx, opcode); // 4

bpf_trace_printk("Another syscall: %d", opcode); // 5

return 0;

}

int hello_exec(void *ctx) { // 6

bpf_trace_printk("Executing a program");

return 0;

}

int hello_timer(struct bpf_raw_tracepoint_args *ctx) { // 7

int opcode = ctx->args[1];

switch (opcode) {

case 222:

bpf_trace_printk("Creating a timer");

break;

case 226:

bpf_trace_printk("Deleting a timer");

break;

default:

bpf_trace_printk("Some other timer operation");

break;

}

return 0;

}

int ignore_opcode(void *ctx) { // 8

return 0;

}

- BCC 提供了一个

BPF_PROG_ARRAY宏,用于轻松定义BPF_MAP_TYPE_PROG_ARRAY类型的映射。我将该映射命名为syscall,并设置了 300 个条目9,对于这个示例来说应该足够了。 - 在您稍后将看到的用户空间代码中,我将把这个 eBPF 程序附加到

sys_enter原始跟踪点(raw tracepoint),任何系统调用都会触发该程序。附加到原始跟踪点的 eBPF 程序接收的上下文以bpf_raw_tracepoint_args结构体的形式传递。 - 对于

sys_enter,原始跟踪点参数包括用于标识正在进行的系统调用的操作码(opcode)。 - 在这里,我们对程序数组中键与操作码匹配的条目进行尾调用。BCC 在将源代码传递给编译器之前,会将这一行代码重写为对

bpf_tail_call()辅助函数的调用。 - 如果尾调用成功,这一行跟踪操作码值的代码将永远不会被执行。我用它来为映射中没有对应程序条目的操作码提供一个默认的跟踪行。

hello_exec()是一个将加载到syscall程序数组映射中的程序。当操作码表示系统调用为execve()时,它将作为尾调用执行。它只是生成一行跟踪,告诉用户一个新程序正在执行。hello_timer()是另一个将加载到syscall程序数组中的程序。在本例中,它将被程序数组中的多个条目引用。ignore_opcode()是一个什么都不做的尾调用程序。我将它用于不希望生成任何跟踪的系统调用。

现在让我们看看加载和管理这一组 eBPF 程序的用户空间代码:

b = BPF(text=program)

b.attach_raw_tracepoint(tp="sys_enter", fn_name="hello") # 1

ignore_fn = b.load_func("ignore_opcode", BPF.RAW_TRACEPOINT) # 2

exec_fn = b.load_func("hello_exec", BPF.RAW_TRACEPOINT)

timer_fn = b.load_func("hello_timer", BPF.RAW_TRACEPOINT)

prog_array = b.get_table("syscall")

prog_array[ct.c_int(59)] = ct.c_int(exec_fn.fd) # 3

prog_array[ct.c_int(222)] = ct.c_int(timer_fn.fd)

prog_array[ct.c_int(223)] = ct.c_int(timer_fn.fd)

prog_array[ct.c_int(224)] = ct.c_int(timer_fn.fd)

prog_array[ct.c_int(225)] = ct.c_int(timer_fn.fd)

prog_array[ct.c_int(226)] = ct.c_int(timer_fn.fd)

# 忽略一些经常出现的系统调用

prog_array[ct.c_int(21)] = ct.c_int(ignore_fn.fd)

prog_array[ct.c_int(22)] = ct.c_int(ignore_fn.fd)

prog_array[ct.c_int(25)] = ct.c_int(ignore_fn.fd)

...

b.trace_print()

- 这次,用户空间代码不是附加到 kprobe,而是将主 eBPF 程序附加到

sys_enter跟踪点。 - 调用

b.load_func()会为每个尾调用程序返回一个文件描述符。注意,尾调用需要与其父程序具有相同的程序类型——在此示例中是BPF.RAW_TRACEPOINT。同时需要指出的是,每个尾调用程序本身也是一个独立的 eBPF 程序。 - 用户空间代码在

syscall映射中创建条目。不必为每个可能的操作码都填充条目;如果某个特定操作码没有条目,这只是意味着不会执行尾调用。此外,多个条目指向同一个 eBPF 程序是完全可以的。在这种情况下,我希望hello_timer()尾调用被执行以处理一组与计时器相关的系统调用。 - 系统中的某些系统调用被系统频繁地运行,如果为每个系统调用都生成一行跟踪信息,会导致跟踪输出混乱到无法阅读的程度。对于某些系统调用,我使用了

ignore_opcode()尾调用来处理。 - 将跟踪输出打印到屏幕上,直到用户终止程序。

运行此程序会为(虚拟)机器上运行的每个系统调用生成跟踪输出,除非操作码对应的条目链接到 ignore_opcode() 尾调用。以下是从另一个终端运行 ls 命令的示例输出(为了可读性省略了一些细节):

./hello-tail.py

b' hello-tail.py-2767 ... Another syscall: 62'

b' hello-tail.py-2767 ... Another syscall: 62'

...

b' bash-2626 ... Executing a program'

b' bash-2626 ... Another syscall: 220'

...

b' <...>-2774 ... Creating a timer'

b' <...>-2774 ... Another syscall: 48'

b' <...>-2774 ... Deleting a timer'

...

b' ls-2774 ... Another syscall: 61'

b' ls-2774 ... Another syscall: 61'

...

具体执行的系统调用并不是重点,但您可以看到不同的尾调用被调用并生成跟踪消息。您还可以看到,对于在尾调用程序映射中没有对应条目的操作码,会生成默认消息 Another syscall。

note

请查阅 Paul Chaignon 关于不同内核版本上BPF 尾调用代价的博客文章。

自内核版本 4.2 起,eBPF 开始支持尾调用,但在很长一段时间内,尾调用与 BPF 到 BPF 函数调用(BPF to BPF function calls)是不兼容的。这一限制在内核版本 5.10 中被解除10。

尾调用最多可以链式组合达到 33 次,再加上每个 eBPF 程序的指令复杂度限制为 100 万条指令,这意味着如今的 eBPF 程序员在编写完全在内核中运行的非常复杂的代码方面有很大的灵活性。

总结

希望通过展示一些具体的 eBPF 程序示例,本章可以帮助您巩固在内核中运行、由事件触发的 eBPF 代码的思维模型。您还看到了使用 BPF 映射从内核向用户空间传递数据的示例。

使用 BCC 框架隐藏了许多关于程序如何构建、加载到内核以及附加到事件的细节。在下一章中,我将向您展示编写“Hello World”的另一种方法,并深入探讨这些隐藏的细节。

练习

如果您想进一步探索 "Hello World",这里有一些可选的活动,您可能想尝试一下(或思考一下):

-

修改 eBPF 程序 hello-buffer.py,使其对奇数和偶数进程 ID 输出不同的跟踪消息。

-

修改 hello-map.py,使 eBPF 代码由多个系统调用触发。例如,

openat()常用于打开文件,write()用于向文件写入数据。您可以先将 hello eBPF 程序附加到多个系统调用 kprobes。然后尝试为不同的系统调用修改 eBPF 程序 hello 的版本,证明您可以从多个不同的程序访问同一个映射。 -

eBPF 程序 hello-tail.py 是一个附加到

sys_enter原始跟踪点的示例。任何系统调用被调用时,都会触发该跟踪点。修改 hello-map.py ,通过将其附加到相同的sys_enter原始跟踪点,展示每个用户 ID 发出的总系统调用的数量。 以下是我做出该修改后得到的一些示例输出:$ ./hello-map.py ID 104: 6 ID 0: 225 ID 104: 6 ID 101: 34 ID 100: 45 ID 0: 332 ID 501: 19 ID 104: 6 ID 101: 34 ID 100: 45 ID 0: 368 ID 501: 38 ID 104: 6 ID 101: 34 ID 100: 45 ID 0: 533 ID 501: 57 -

BCC 提供的

RAW_TRACEPOINT_PROBE宏简化了附加到原始跟踪点的过程,它会告诉用户空间 BCC 代码自动将其附加到指定的跟踪点。尝试在 hello-tail.py 中使用它,如下所示:- 将

hello()函数的定义替换为RAW_TRACEPOINT_PROBE(sys_enter)。 - 从 Python 代码中移除显式的附加调用

b.attach_raw_tracepoint()。

您应该会看到 BCC 自动附加,并且程序工作正常。这是 BCC 提供的许多方便宏的一个示例。

- 将

-

您可以进一步修改 hello_map.py,使哈希表中的键标识特定的系统调用(而不是特定的用户)。输出将显示整个系统中该系统调用被调用的次数。

我最初为一个名为“eBPF 编程初学者指南”的讲座编写了这段代码。您可以在 https://github.com/lizrice/ebpf-beginners 找到原始代码以及幻灯片和视频的链接。

从 5.5 版本的内核开始,有一种更高效的方式来将 eBPF 程序附加到函数上,这种方式使用 fentry(以及相应的 fexit,代替 kretprobe 用于函数的退出)。我会在本书后面的章节中讨论这个话题,但现在为了使本章的示例尽可能简单,我仍然使用 kprobe。

我经常使用 VSCode 远程连接到云中的虚拟机。这台虚拟机上运行了大量的 Node 脚本,生成了很多来自这个“Hello World”应用的跟踪信息。

一些命令(比如 echo 是一个常见的例子)可能是 shell 内置命令,这些命令作为 shell 进程的一部分运行,而不是执行一个新的程序。因此,这些命令不会触发 execve() 事件,所以不会生成跟踪信息。

C++ 支持,但 C 不支持。

低 32 位是线程组 ID(thread group ID)。对于单线程进程,这与进程 ID 相同;对于多线程进程,额外的线程会被分配不同的 ID。GNU C 库的文档对进程 ID 和线程组 ID 之间的区别有很好的描述。

这只是示例代码,所以我不担心在键盘中断或其他细节上的清理工作!

这一原则通常被称为“DRY”(“Don’t Repeat Yourself”),由《程序员修炼之道》(The Pragmatic Programmer)推广。

在 Linux 中有大约 300 个系统调用,由于在这个示例中我没有使用最近添加的系统调用,所以这个数量已经足够了。

从 BPF 子程序中进行尾调用需要 JIT 编译器的支持,您将在下一章中遇到这个概念。在我用来编写本书示例的内核版本中,只有 x86 的 JIT 编译器支持这一功能,尽管在 6.0 版本的内核中,ARM 也添加了对这一功能的支持。

第 3 章 eBPF 程序剖析

在前一章中,您已经看到了一个使用 BCC 框架编写的简单的 eBPF“Hello World”程序。在本章中,有一个完全用 C 语言编写的“Hello World”程序示例,以便您能够看到 BCC 在幕后处理的一些细节。

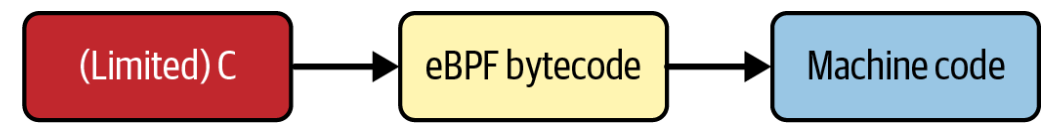

本章还展示了 eBPF 程序从源代码到执行过程中所经历的各个阶段,如图 3-1 所示。

图 3-1. C(或 Rust)源代码被编译为 eBPF 字节码,该字节码要么可以被即时编译(JIT-compiled),要么被解释成本地机器代码指令

eBPF 程序是一组 eBPF 字节码指令。可以直接用编写 eBPF 字节码的方式编写 eBPF 代码,就像可以用汇编语言编程一样。通常,人们更容易处理高级编程语言。至少在撰写本文时,我可以说绝大多数 eBPF 代码是用 C 语言1编写的,然后编译成 eBPF 字节码。

从概念上讲,这些字节码在内核中的 eBPF 虚拟机中运行。

eBPF 虚拟机

eBPF 虚拟机,和其他虚拟机一样,是计算机软件实现的。它接收以 eBPF 字节码指令形式表示的程序,并将这些指令转换为在 CPU 上运行的本地机器指令。

在早期的 eBPF 实现中,字节码指令是在内核中解释执行的——也就是说,每次运行 eBPF 程序时,内核都会检查指令并将其转换为机器码,然后执行它们。出于性能原因以及为了避免 eBPF 解释器中出现一些 Spectre 相关的漏洞,解释执行已在很大程度上被即时(just-in-time,JIT)编译替代。编译意味着当程序加载到内核时,从字节码到本机机器指令的转换只发生一次。

eBPF 字节码由一组指令组成,这些指令作用于(虚拟的)eBPF 寄存器。eBPF 指令集和寄存器模型的设计旨在与常见的 CPU 架构相匹配,以便将字节码编译或解释为机器码的步骤相对简单。

eBPF 寄存器

eBPF 虚拟机使用 10 个通用寄存器,编号从 0 到 9。此外,寄存器 10 被用作栈帧指针(只能读取,不能写入)。在执行 BPF 程序时,这些寄存器中存储的值用于跟踪状态。

需要理解的是,eBPF 虚拟机中的这些寄存器是通过软件实现的。您可以在 Linux 内核源代码的 include/uapi/linux/bpf.h 头文件中看到它们,从 BPF_REG_0 到 BPF_REG_10。

在 eBPF 程序开始执行之前,上下文参数被加载到寄存器 1 中。函数的返回值存储在寄存器 0 中。

eBPF 代码在调用函数之前,该函数的参数被放置在寄存器 1 到寄存器 5 中(如果参数少于五个,则不会使用所有寄存器)。

eBPF 指令

同样的 linux/bpf.h 头文件定义了一个名为 bpf_insn 的结构体,该结构体代表一条 BPF 指令:

struct bpf_insn {

__u8 code; /* opcode */ // 1

__u8 dst_reg:4; /* dest register */ // 2

__u8 src_reg:4; /* source register */

__s16 off; /* signed offset */ // 3

__s32 imm; /* signed immediate constant */

};

- 每条指令都有一个操作码,用于定义该指令要执行的操作:例如,将一个值加到寄存器(所存储的值)中,或跳转到程序中的另一条指令2。Iovisor 项目的“非官方 eBPF 规范(Unofficial eBPF spec)”中列出了有效指令的列表。

- 不同的操作可能涉及最多两个寄存器。

- 根据操作的不同,可能还会有一个偏移值和/或一个“立即”整数值。

bpf_insn 结构体的长度为 64 位(或 8 字节)。然而,有时一条指令可能需要多于 8 字节的空间。如果要将寄存器设置为 64 位值,则无法将该值的所有 64 位与操作码和寄存器信息一起挤进一个结构体中。在这些情况下,指令使用总长度为 16 字节的宽指令编码。您将在本章中看到这方面的示例。

当加载到内核中时,eBPF 程序的字节码由一系列 bpf_insn 结构体表示。验证器对这些信息进行多项检查,以确保代码的运行安全。您将在第 6 章中了解更多关于验证过程的内容。

大多数不同的操作码可以分为以下几类:

- 将一个值加载到寄存器中(可以是立即数、从内存或其他寄存器读取的值)

- 将一个寄存器中的值存储到内存中

- 执行算术操作,例如,将一个值加到寄存器中

- 如果满足特定条件,则跳转到另一条指令

note

关于 eBPF 架构的概述,我推荐 Cilium 项目文档中的 BPF 和 XDP 参考指南。如果您需要更多详细信息,内核文档清晰的描述了 eBPF 指令和编码。

让我们使用另一个简单的 eBPF 程序示例,并跟踪它从 C 源代码,到 eBPF 字节码,再到机器码指令的过程。

note

如果您想自己构建并运行此代码,可以在 github.com/lizrice/learning-ebpf 上找到代码及设置环境的说明。本章的代码在 chapter3 目录中。

本章中的示例是使用名为 libbpf 的库,用 C 语言编写的。您将在第 5 章中了解有关该库的更多信息。

用于网络接口的 eBPF “Hello World”

上一章中的示例通过系统调用的 kprobe 触发了“Hello World”的跟踪输出;这次我要展示一个 eBPF 程序,当网络数据包到达时触发,输出一行跟踪信息。

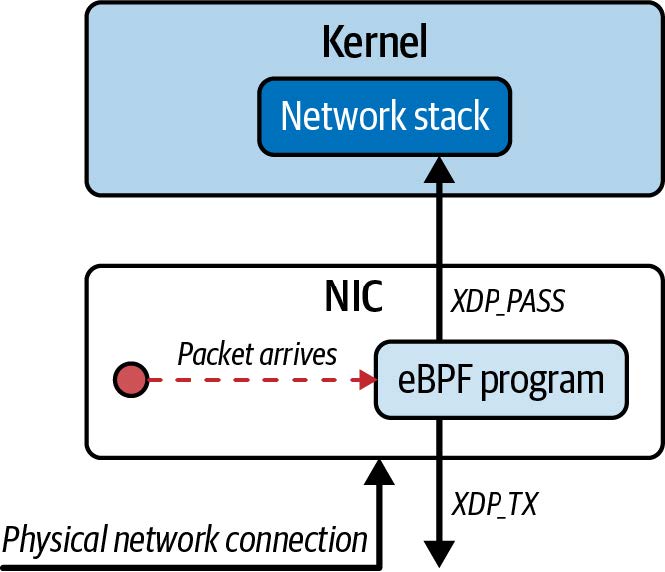

数据包处理是 eBPF 的一个非常常见的应用。在第 8 章中,我将详细介绍这个内容。但现在,了解每次数据包到达网络接口时,会触发 eBPF 程序的基本概念可能会有所帮助。该程序可以检查甚至修改数据包的内容,并对内核如何处理该数据包做出决定(或判决(verdict))。判决可以指示内核按常规处理它、丢弃它或将其重定向到其他地方。

在这里展示的简单示例中,程序不会对网络数据包做任何处理;它只是在每次接收到网络数据包时,将 Hello World 和一个计数器写入跟踪管道。

示例程序位于 chapter3/hello.bpf.c 中。为了将 eBPF 程序与可能存在于相同源代码目录中的用户空间 C 代码区分开来,将 eBPF 程序放在以 bpf.c 结尾的文件名中是一种相当常见的约定。以下是整个程序:

#include <linux/bpf.h> // 1

#include <bpf/bpf_helpers.h>

int counter = 0; // 2

SEC("xdp") // 3

int hello(struct xdp_md *ctx) { // 4

bpf_printk("Hello World %d", counter);

counter++;

return XDP_PASS;

}

char LICENSE[] SEC("license") = "Dual BSD/GPL"; // 5

- 此示例首先包含了一些头文件。假设您不熟悉 C 编程,每个程序都必须包含定义程序将要使用的任何结构体或函数的头文件。从这些头文件的名称可以看出,它们与 BPF 有关。

- 该示例展示了 eBPF 程序如何使用全局变量。每次程序运行时,这个计数器都会递增。

- 宏

SEC()定义了一个名为xdp的段(section),您将在编译后的目标文件中看到它。稍后在第 5 章中,我会详细解释段名称的用法,但现在您可以简单地将其视为定义一个 eXpress Data Path(XDP)类型的 eBPF 程序。 - 这里可以看到实际的 eBPF 程序。在 eBPF 中,程序名称就是函数名称,所以这个程序名为

hello。它使用一个辅助函数bpf_printk来输出一串文本,递增全局变量counter,然后返回值XDP_PASS。这是指示内核正常处理此网络包的判决。 - 最后,还有另一个定义许可证字符串的

SEC()宏,这是 eBPF 程序的关键要求。内核中的一些 BPF 辅助函数被定义为“仅限 GPL(GPL only)”。如果您想使用这些函数,您的 BPF 代码必须声明为具有 GPL 兼容的许可证。如果声明的许可证与程序使用的函数不兼容,验证器(我们将在第 6 章中讨论)会拒绝加载。某些类型的 eBPF 程序,包括使用 BPF LSM 的程序(将在第 9 章介绍),也必须符合 GPL 兼容性要求。

note

您可能想知道为什么前一章使用 bpf_trace_printk() ,而这个版本使用 bpf_printk()。简而言之,BCC 的版本叫做 bpf_trace_printk(),而 libbpf 的版本叫做 bpf_printk(),但这两个都是对内核函数 bpf_trace_printk() 的封装。Andrii Nakryiko 在他的博客上写了一篇很好的贴子。

这是一个附加到网络接口上的 XDP 钩子点的 eBPF 程序示例。您可以将 XDP 事件视为在网络数据包到达(物理或虚拟)网络接口时立即触发。

note

一些网卡支持将 XDP 程序卸载(offload)到网卡本身执行。这意味着每个到达的网络数据包都可以在网卡上处理,而不会接触到机器的 CPU。XDP 程序可以检查甚至修改每个网络数据包,因此这对于进行 DDoS 防护、防火墙或负载均衡等高性能操作非常有用。您将在第 8 章中进一步了解此功能。

您已经看到了 C 源代码,下一步是将其编译成内核可以理解的目标文件。

编译 eBPF 目标文件

我们的 eBPF 源代码需要编译成 eBPF 虚拟机能理解的机器指令:eBPF 字节码。LLVM 项目中的 Clang 编译器可以通过指定 -target bpf 来完成这项任务。以下是一个 Makefile 的摘录,用于进行编译:

hello.bpf.o: %.o: %.c

clang \

-target bpf \

-I/usr/include/$(shell uname -m)-linux-gnu \

-g \

-O2 -c $< -o $@

这将从 hello.bpf.c 源代码生成一个名为 hello.bpf.o 的目标文件。这里的 -g 标志是可选的3,它可以生成调试信息,这样您在检查目标文件时可以同时看到源代码和字节码。让我们检查一下这个目标文件,以便更好地理解它包含的 eBPF 代码。

检查 eBPF 目标文件

通常使用 file 工具来确定文件的内容:

$ file hello.bpf.o

hello.bpf.o: ELF 64-bit LSB relocatable, eBPF, version 1 (SYSV), with debug_info, not stripped

这表明它是一个 ELF(Executable and Linkable Format,可执行和可链接格式)文件,包含 eBPF 代码,适用于具有 LSB(最低有效位)架构的 64 位平台。如果在编译步骤中使用了-g标志,它将包含调试信息。

您可以使用 llvm-objdump 进一步检查此目标文件,以查看其中的 eBPF 指令:

$ llvm-objdump -S hello.bpf.o

即使您不熟悉反汇编,此命令的输出也不难理解:

hello.bpf.o: file format elf64-bpf # 1

Disassembly of section xdp: # 2

0000000000000000 <hello>: # 3

; bpf_printk("Hello World %d", counter); # 4

0: 18 06 00 00 00 00 00 00 00 00 00 00 00 00 00 00 r6 = 0 ll

2: 61 63 00 00 00 00 00 00 r3 = *(u32 *)(r6 + 0)

3: 18 01 00 00 00 00 00 00 00 00 00 00 00 00 00 00 r1 = 0 ll

5: b7 02 00 00 0f 00 00 00 r2 = 15

6: 85 00 00 00 06 00 00 00 call 6

; counter++; # 5

7: 61 61 00 00 00 00 00 00 r1 = *(u32 *)(r6 + 0)

8: 07 01 00 00 01 00 00 00 r1 += 1

9: 63 16 00 00 00 00 00 00 *(u32 *)(r6 + 0) = r1

; return XDP_PASS; # 6

10: b7 00 00 00 02 00 00 00 r0 = 2

11: 95 00 00 00 00 00 00 00 exit

- 第一行进一步确认了 hello.bpf.o 是一个 64 位 ELF 文件,包含 eBPF 代码(有些工具使用 BPF 术语,有些使用 eBPF 术语,没有特别的原因;正如之前所说,这些术语现在几乎是可以互换使用)。

- 接下来是

xdp段的反汇编,与 C 源代码中的SEC()定义相匹配。 - 该段是一个名为

hello的函数。 - 源代码中的

bpf_printk("Hello World %d", counter");行对应的五行 eBPF 字节码指令。 - 三行 eBPF 字节码指令用于增加变量

counter。 - 另外两行字节码由源代码

return XDP_PASS;生成。

除非您特别有兴趣,否则没有必要准确理解每行字节码如何与源代码相关联。编译器会生成字节码,使您不必去考虑这些细节!但让我们稍微详细地查看输出,以便您能够了解这些输出与您本章早些时候学习的 eBPF 指令和寄存器之间的关系。

在每行字节码的左侧,您可以看到该指令在内存中相对于 hello 所在位置的偏移量。正如本章前面所述,eBPF 指令长度通常是 8 字节,而在 64 位平台上,每个内存位置可以容纳 8 字节,因此偏移量通常会每条指令递增 1。然而,该程序中的第一条指令恰好需要 16 字节的宽指令编码,以便将寄存器 6 设置为 64 位值 0。因此,输出的第二行指令的偏移量为 2。之后还有一个 16 字节的指令,将寄存器 1 设置为 64 位值 0。再往后,剩下的指令每条占用 8 字节,因此每行的偏移量递增一。

每行的第一个字节是操作码,指示内核执行的操作,指令行的右侧是人类可读的指令解释。撰写本文时,Iovisor 项目有最完整的 eBPF 操作码文档,但官方的 Linux 内核文档正在逐步完善,eBPF 基金会正在制定不依赖于特定操作系统的标准文档。

例如,我们来看一下偏移量为 5 的指令,如下所示:

5: b7 02 00 00 0f 00 00 00 r2 = 15

这条指令的操作码是0xb7,根据文档的说明,其对应的伪代码是 dst = imm,可以理解为“将目标寄存器设置为立即数”。目标由第二个字节 0x02 定义,表示“寄存器 2”。这里的“立即”(或字面)数是 0x0f,即十进制的 15。因此,我们可以理解这条指令是告诉内核“将寄存器 2 设置为值 15”。这与指令右侧看到的输出相对应:r2 = 15。

偏移量为 10 的指令类似:

10: b7 00 00 00 02 00 00 00 r0 = 2

这行指令同样使用操作码 0xb7,这次是将寄存器 0 的值设置为 2。当一个 eBPF 程序运行结束时,寄存器 0 存放返回值,而 XDP_PASS 的值是 2。这与源代码中的逻辑一致,即始终返回 XDP_PASS。

您现在知道了 hello.bpf.o 包含一个以字节码形式存在的 eBPF 程序。下一步是将其加载到内核中。

将程序加载到内核中

在这个示例中,我们将使用一个名为 bpftool 的工具。您也可以通过编程的方式加载程序,稍后在书中您将看到相关示例。

note

某些 Linux 发行版提供了包含 bpftool 的软件包,或者您可以从源代码编译。您可以在 Quentin Monnet 的博客上找到有关安装或构建此工具的更多详细信息,也可以在 Cilium 网站上找到更多文档和用法。

下面是使用 bpftool 将程序加载到内核的示例。请注意,您可能需要以 root 身份(或使用 sudo)获得 bpftool 所需的 BPF 权限。

$ bpftool prog load hello.bpf.o /sys/fs/bpf/hello

这将从我们编译的目标文件中加载 eBPF 程序,并将其“固定”到位置 /sys/fs/bpf/hello4。对于该命令,没有输出响应表明成功,您也可以使用 ls 确认程序是否已就位:

$ ls /sys/fs/bpf

hello

eBPF 程序已成功加载。让我们使用 bpftool 工具了解有关该程序及其在内核中的状态的更多信息。

检查已加载的程序

bpftool 工具可以列出加载到内核中的所有程序。如果您自己尝试,可能会在输出中看到几个预先存在的 eBPF 程序,但为了清楚起见,我只展示与我们的“Hello World”示例相关的行:

$ bpftool prog list

...

540: xdp name hello tag d35b94b4c0c10efb gpl

loaded_at 2022-08-02T17:39:47+0000 uid 0

xlated 96B jited 148B memlock 4096B map_ids 165,166

btf_id 254

程序已被分配 ID 540。此标识是为每个加载的程序分配的编号。知道 ID 后,您可以使用 bpftool 显示有关此程序的更多信息。这次,我们以美化的 JSON 格式输出,以便字段名称和值可见:

$ bpftool prog show id 540 --pretty

{

"id": 540,

"type": "xdp",

"name": "hello",

"tag": "d35b94b4c0c10efb",

"gpl_compatible": true,

"loaded_at": 1659461987,

"uid": 0,

"bytes_xlated": 96,

"jited": true,

"bytes_jited": 148,

"bytes_memlock": 4096,

"map_ids": [165,166

],

"btf_id": 254

}

根据字段名称,很多内容都很容易理解:

- 程序的 ID 是 540。

type字段告诉我们这个程序可以使用 XDP 事件附加到网络接口。其他类型的 BPF 程序可以附加到不同类型的事件上,我们将在第七章中详细讨论这一点。- 程序名称为

hello,这是源代码中的函数名称。 tag是该程序的另一个标识符,我稍后会详细描述。- 该程序采用 GPL 兼容许可证。

- 有一个时间戳显示程序的加载时间。

- 用户 ID 0(即 root)加载了该程序。

- 此程序中有 96 字节的翻译后的 eBPF 字节码,我会在稍后向您展示。

- 该程序已经过 JIT 编译,编译产生了 148 字节的机器码,我也会在稍后介绍。

bytes_memlock字段告诉我们,此程序保留了 4,096 字节的内存,这些内存不会被分页。- 该程序引用了 ID 为 165 和 166 的 BPF 映射。由于在源代码中没有明显的映射引用,这可能会让人感到意外。您将在本章稍后看到如何使用映射语义来处理 eBPF 程序中的全局数据。

- 您将在第 5 章学习有关 BTF 的内容,现在只需要知道

btf_id表示该程序有一个 BTF 信息块。只有在使用-g标志进行编译时,才会将此信息包含在目标文件中。

BPF 程序标签(tag)

标签(tag)是所有程序指令的 SHA(Secure Hashing Algorithm,安全哈希算法)散列值,可以用作程序的另一个标识符。每次加载或卸载程序时,ID 可能会变化,但标签将保持不变。bpftool 工具接受通过 ID、名称、标签或固定路径来引用 BPF 程序,因此在此示例中,以下所有命令将给出相同的输出:

bpftool prog show id 540bpftool prog show name hellobpftool prog show tag d35b94b4c0c10efbbpftool prog show pinned /sys/fs/bpf/hello

您可以拥有多个同名的程序,甚至是具有相同标签的多个程序实例,但 ID 和固定路径始终是唯一的。

翻译后的字节码

bytes_xlated 字段告诉我们有多少字节的“翻译后”eBPF 代码。这是 eBPF 字节码在通过验证器之后(并可能被内核修改,原因我将在本书后面讨论)得到的结果。

让我们使用 bpftool 来显示我们“Hello World”代码的翻译版本:

$ bpftool prog dump xlated name hello

int hello(struct xdp_md * ctx):

; bpf_printk("Hello World %d", counter);

0: (18) r6 = map[id:165][0]+0

2: (61) r3 = *(u32 *)(r6 +0)

3: (18) r1 = map[id:166][0]+0

5: (b7) r2 = 15

6: (85) call bpf_trace_printk#-78032

; counter++;

7: (61) r1 = *(u32 *)(r6 +0)

8: (07) r1 += 1

9: (63) *(u32 *)(r6 +0) = r1

; return XDP_PASS;

10: (b7) r0 = 2

11: (95) exit

这与您之前从 llvm-objdump 输出中看到的反汇编代码非常相似。偏移地址相同,指令也相似——例如,我们可以看到偏移量为 5 的指令是 r2=15。

JIT 编译的机器代码

翻译后的字节码虽然很低级,但还不是机器代码。eBPF 使用 JIT 编译器将 eBPF 字节码转换为在目标 CPU 上本地运行的机器代码。bytes_jited 字段显示,经此转换之后,程序长度为 108 字节。

note

为了获得更高的性能,eBPF 程序通常会进行 JIT 编译。另一种选择是在运行时解释 eBPF 字节码。eBPF 指令集和寄存器的设计与本机机器指令相当接近,使得解释直接且相对快速,但编译后的程序会更快,现在大多数架构都支持 JIT5。

bpftool 工具可以生成这个 JIT 代码的汇编语言转储。即便您对汇编语言不熟悉,这看起来完全不可理解也无需担心!我之所以将其包括在内,是为了展示 eBPF 代码从源代码到可执行机器指令所经历的所有转换过程。以下是命令及其输出:

$ bpftool prog dump jited name hello

int hello(struct xdp_md * ctx):

bpf_prog_d35b94b4c0c10efb_hello:

; bpf_printk("Hello World %d", counter);

0: hint #34

4: stp x29, x30, [sp, #-16]!

8: mov x29, sp

c: stp x19, x20, [sp, #-16]!

10: stp x21, x22, [sp, #-16]!

14: stp x25, x26, [sp, #-16]!

18: mov x25, sp

1c: mov x26, #0

20: hint #36

24: sub sp, sp, #0

28: mov x19, #-140733193388033

2c: movk x19, #2190, lsl #16

30: movk x19, #49152

34: mov x10, #0

38: ldr w2, [x19, x10]

3c: mov x0, #-205419695833089

40: movk x0, #709, lsl #16

44: movk x0, #5904

48: mov x1, #15

4c: mov x10, #-6992

50: movk x10, #29844, lsl #16

54: movk x10, #56832, lsl #32

58: blr x10

5c: add x7, x0, #0

; counter++;

60: mov x10, #0

64: ldr w0, [x19, x10]

68: add x0, x0, #1

6c: mov x10, #0

70: str w0, [x19, x10]

; return XDP_PASS;

74: mov x7, #2

78: mov sp, sp

7c: ldp x25, x26, [sp], #16

80: ldp x21, x22, [sp], #16

84: ldp x19, x20, [sp], #16

88: ldp x29, x30, [sp], #16

8c: add x0, x7, #0

90: ret

note

某些打包的 bpftool 发行版尚不支持转储 JIT 输出。如果出现这种情况,您将看到“Error: No libbfd support.”。您可以按照 https://github.com/libbpf/bpftool 上的说明自行构建 bpftool。

您已经看到,“Hello World”程序已加载到内核中,但此时它尚未与事件关联,因此没有任何东西会触发它运行。它需要附加到一个事件上。

附加到事件

程序类型必须与其附加的事件类型匹配;您将在第 7 章中了解更多相关信息。本示例是一个 XDP 程序,您可以使用 bpftool 将示例 eBPF 程序附加到网络接口上的 XDP 事件,如下所示:

$ bpftool net attach xdp id 540 dev eth0

note

在撰写本文时,bpftool 工具还不支持附加所有程序类型,但最近已扩展以自动附加 k(ret)probes、u(ret)probes 和 tracepoints。

这里,我使用了程序的 ID 540,但您也可以使用名称(前提是它是唯一的)或标签来标识要附加的程序。在此示例中,我已将程序附加到网络接口 eth0。

您可以使用 bpftool 查看所有网络附加的 eBPF 程序:

$ bpftool net list

xdp:

eth0(2) driver id 540

tc:

flow_dissector:

ID 为 540 的程序已附加到 eth0 接口上的 XDP 事件。此输出还提供了一些有关网络协议栈中可以附加 eBPF 程序的其他潜在事件的线索:tc 和 flow_dissector。更多内容请参阅第 7 章。

您还可以使用 ip link 检查网络接口,输出如下所示(为清晰起见,已删除了一些细节):

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN mode DEFAULT

group default qlen 1000

...

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 xdp qdisc fq_codel state UP

mode DEFAULT group default qlen 1000

...

prog/xdp id 540 tag 9d0e949f89f1a82c jited

...

在此示例中,有两个接口:用于将流量发送到本机进程的回环接口 lo,以及将本机连接到外界的 eth0 接口。此输出还显示 eth0 有一个 JIT 编译的 eBPF 程序,其 ID 为 540,标签为 9d0e949f89f1a82c,附加到其 XDP 钩子上。

note

您也可以使用 ip link 将 XDP 程序附加到网络接口或将其从接口分离。我已将其作为本章结尾的练习,并在第 7 章中提供了更多示例。

此时,每当接收到网络数据包时,eBPF 程序 hello 会产生跟踪输出。您可以通过运行 cat /sys/kernel/debug/tracing/trace_pipe 来检查。这应该会显示大量类似如下的输出:

<idle>-0 [003] d.s.. 655370.944105: bpf_trace_printk: Hello World 4531

<idle>-0 [003] d.s.. 655370.944587: bpf_trace_printk: Hello World 4532

<idle>-0 [003] d.s.. 655370.944896: bpf_trace_printk: Hello World 4533

如果您不记得跟踪管道的位置,可以使用命令 bpftool prog tracelog 获得相同的输出。

与第 2 章中的输出相比,这次每个事件都没有与之关联的命令或进程 ID;而是看到每行跟踪的开头都是 <idle>-0。在第 2 章中,每个系统调用事件都是因为用户空间中执行命令的进程调用了系统调用 API。该进程 ID 和命令是 eBPF 程序执行的上下文的一部分。但在这里的示例中,XDP 事件是由于网络数据包的到达而发生的。此时没有与该数据包关联的用户空间进程——当 eBPF 程序 hello 被触发时,系统除了在内存中接收该数据包外,还没有对其执行任何操作,也不知道该数据包是什么或要去哪里。

正如预期的那样,您可以看到跟踪输出的计数器值每次递增 1。在源代码中,counter 是一个全局变量。让我们看看如何在 eBPF 中使用映射实现这一点。

全局变量

正如您在前一章中所了解到的,eBPF 映射是一种可以从 eBPF 程序或用户空间访问的数据结构。由于同一映射可以由同一程序的不同运行多次访问,因此它可以用于在不同执行之间保存状态。多个程序也可以访问同一映射。由于这些特性,映射语义可以被用作全局变量。

note

在 2019 年增加对全局变量的支持之前,eBPF 程序员必须显式编写映射来执行相同的任务。

您之前看到 `bpftool 显示此示例程序使用了两个 ID 为 165 和 166 的映射。(如果您自己尝试,可能会看到不同的 ID,因为这些 ID 是在内核中创建映射时分配的)。让我们来探索一下这些映射包含的内容。

bpftool 工具可以显示加载到内核中的映射。为清晰起见,我将只展示与“Hello World”示例程序相关的条目 165 和 166:

$ bpftool map list

165: array name hello.bss flags 0x400

key 4B value 4B max_entries 1 memlock 4096B

btf_id 254

166: array name hello.rodata flags 0x80

key 4B value 15B max_entries 1 memlock 4096B

btf_id 254 frozen

在从 C 程序编译的目标文件中,bss6 段通常保存全局变量,您可以使用 bpftool 检查其内容,如下所示:

$ bpftool map dump name hello.bss

[{

"value": {

".bss": [{

"counter": 11127

}

]

}

}

]

我也可以使用 bpftool map dump id 165 来检索相同的信息。如果我再次运行这些命令中的任何一个,我会看到计数器增加了,因为每当接收到网络数据包时,程序都会运行。

正如您将在第 5 章中了解到的,bpftool 只有在 BTF 信息可用时才能美化地打印出映射中的字段名称(在这里是变量名称 counter),并且只有在使用 -g 标志编译时才会包含这些信息。如果在编译步骤中省略了该标志,您会看到如下内容:

$ bpftool map dump name hello.bss

key: 00 00 00 00 value: 19 01 00 00

Found 1 element

没有 BTF 信息,bpftool 无法知道源代码中使用的变量名称。由于此映射中只有一项,您可以推断出十六进制值 19 01 00 00 必定是 counter 的当前值(十进制为 281,因为字节的顺序最低有效位)。

您在此看到 eBPF 程序使用映射语义来读写全局变量。在检查另一个映射时,如您所见,映射还用于保存静态数据。

另一个名为 hello.rodata 的映射暗示这可能是与我们的 hello 程序相关的只读数据。您可以转储此映射的内容,以查看它包含 eBPF 程序用于跟踪的字符串:

$ bpftool map dump name hello.rodata

[{

"value": {

".rodata": [{

"hello.____fmt": "Hello World %d"

}

]

}

}

]

如果您没有使用 -g 标志编译目标文件,您将看到如下输出:

$ bpftool map dump id 166

key: 00 00 00 00 value: 48 65 6c 6c 6f 20 57 6f 72 6c 64 20 25 64 00

Found 1 element

此映射中有一个键值对,该值包含以 0 结尾的 12 个字节的数据。您可能不会惊讶于这些字节是字符串 "Hello World %d" 的 ASCII 表示。

现在我们已经完成了对这个程序及其映射的检查,是时候清理它了。我们首先将其与触发它的事件分离。

分离程序

您可以通过如下命令将程序从网络接口分离(detach):

$ bpftool net detach xdp dev eth0

如果该命令成功运行,则不会有输出,但您可以通过 bpftool net list 的输出中缺少 XDP 条目,来确认程序已不再附加:

$ bpftool net list

xdp:

tc:

flow_dissector:

然而,程序仍然加载在内核中:

$ bpftool prog show name hello

395: xdp name hello tag 9d0e949f89f1a82c gpl

loaded_at 2022-12-19T18:20:32+0000 uid 0

xlated 48B jited 108B memlock 4096B map_ids 4

卸载程序

目前,还没有 bpftool prog load 的反向命令(至少在撰写本文时没有),但您可以通过删除固定的伪文件来从内核中移除该程序:

$ rm /sys/fs/bpf/hello

$ bpftool prog show name hello

由于程序不再加载在内核中,因此此 bpftool 命令没有输出。

BPF 到 BPF 调用(BPF to BPF Calls)

在上一章中,您看到了尾调用的应用,并且我提到现在还可以从 eBPF 程序中调用函数。让我们来看一个简单的例子,与尾调用示例一样,将其附加到 sys_enter 跟踪点,但这次它将跟踪输出系统调用的操作码。您可以在 chapter3/hello-func.bpf.c 中找到代码。

出于演示目的,我编写了一个非常简单的函数,用于从跟踪点参数中提取系统调用操作码:

static __attribute((noinline)) int get_opcode(struct bpf_raw_tracepoint_args *ctx) {

return ctx->args[1];

}

在可能的情况下,编译器可能会内联这个非常简单的函数,因为我只会从一个地方调用它。由于这会削弱这个示例的意义,我添加了 __attribute((noinline)) 来强制编译器不内联。在正常情况下,您可能应该省略这一点,并允许编译器根据需要进行优化。

调用该函数的 eBPF 函数如下所示:

SEC("raw_tp")

int hello(struct bpf_raw_tracepoint_args *ctx) {

int opcode = get_opcode(ctx);

bpf_printk("Syscall: %d", opcode);

return 0;

}

将其编译为 eBPF 目标文件后,您可以使用 bpftool 将其加载到内核中并确认它已加载:

$ bpftool prog load hello-func.bpf.o /sys/fs/bpf/hello

$ bpftool prog list name hello

893: raw_tracepoint name hello tag 3d9eb0c23d4ab186 gpl

loaded_at 2023-01-05T18:57:31+0000 uid 0

xlated 80B jited 208B memlock 4096B map_ids 204

btf_id 302

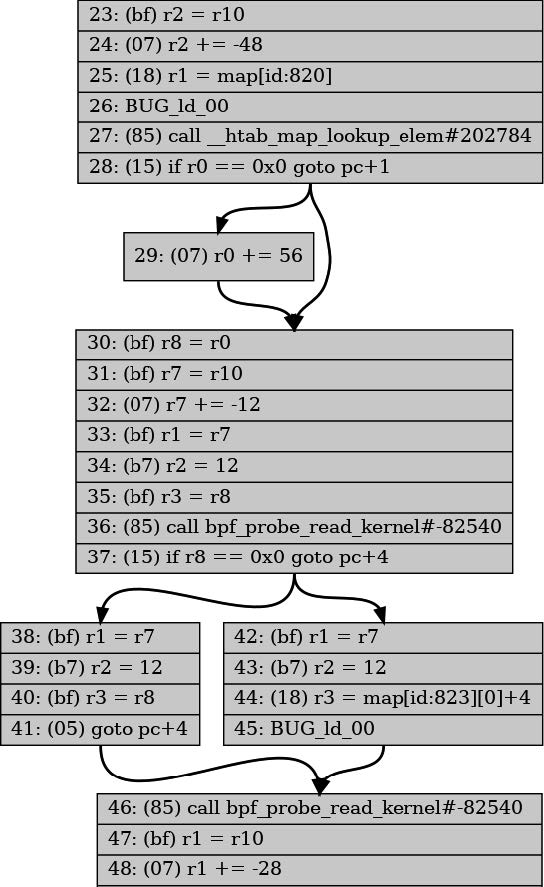

这个练习的有趣部分是检查 eBPF 字节码以查看 get_opcode() 函数:

$ bpftool prog dump xlated name hello

int hello(struct bpf_raw_tracepoint_args * ctx):

; int opcode = get_opcode(ctx); # 1

0: (85) call pc+7#bpf_prog_cbacc90865b1b9a5_get_opcode

; bpf_printk("Syscall: %d", opcode);

1: (18) r1 = map[id:193][0]+0

3: (b7) r2 = 12

4: (bf) r3 = r0

5: (85) call bpf_trace_printk#-73584

; return 0;

6: (b7) r0 = 0

7: (95) exit

int get_opcode(struct bpf_raw_tracepoint_args * ctx): # 2

; return ctx->args[1];

8: (79) r0 = *(u64 *)(r1 +8)

; return ctx->args[1];

9: (95) exit

- 在这里,您可以看到 eBPF 程序

hello()调用了get_opcode()。偏移量为0的 eBPF 指令是0x85,根据指令集文档,对应于“函数调用”。接下来,不会继续执行下一条指令(即偏移量为1的指令),而是会跳过七条指令(pc+7),这意味着将执行偏移量为8的指令。 - 这是

get_opcode()的字节码,正如您所希望的那样,第一条指令偏移量为8。

函数调用指令需要将当前状态放在 eBPF 虚拟机的栈上,以便在被调用函数退出时,可以在调用函数中继续执行。由于栈大小限制为 512 字节,因此 BPF 到 BPF 的调用不能嵌套得太深。

note

关于尾调用和 BPF 到 BPF 调用的更多细节,请参阅 Jakub Sitnicki 在 Cloudflare 博客上的一篇优秀文章:“Assembly within! BPF tail calls on x86 and ARM”。

总结

在本章中,您看到了如何将一些示例 C 源代码转换为 eBPF 字节码,然后编译为机器代码,以便在内核中执行。您还学习了如何使用 bpftool 检查加载到内核中的程序和映射,以及如何附加到 XDP 事件。

此外,您还看到了由不同事件触发的不同类型 eBPF 程序的示例。XDP 事件由网络接口上的数据包到达触发,而 kprobe 和 tracepoint 事件则是通过触发内核代码中的某些特定点来触发。在第 7 章中,我将讨论其他类型的 eBPF 程序。

您还学习了如何使用映射来实现 eBPF 程序的全局变量,并且看到了 BPF 到 BPF 的函数调用。

下一章将更深入地介绍当 bpftool 或其他用户空间代码加载程序并将其附加到事件时,在系统调用级别发生的事情。

练习

以下是一些可供尝试的内容,以便进一步探索 BPF 程序:

-

尝试使用如下所示的

ip link命令来附加和分离 XDP 程序:$ ip link set dev eth0 xdp obj hello.bpf.o sec xdp $ ip link set dev eth0 xdp off -

运行第 2 章中的任何 BCC 示例。当程序正在运行时,在第二个终端窗口使用

bpftool检查加载的程序。以下是我运行 hello-map.py 示例时看到的内容:$ bpftool prog show name hello 197: kprobe name hello tag ba73a317e9480a37 gpl loaded_at 2022-08-22T08:46:22+0000 uid 0 xlated 296B jited 328B memlock 4096B map_ids 65 btf_id 179 pids hello-map.py(2785)您还可以使用

bpftool prog dump命令查看这些程序的字节码和机器码。 -

在 chapter2 目录下运行 hello-tail.py,当它运行时,看看它加载的程序。当它正在运行时,查看它加载的程序。您将看到每个尾调用程序被单独列出,如下所示:

$ bpftool prog list ... 120: raw_tracepoint name hello tag b6bfd0e76e7f9aac gpl loaded_at 2023-01-05T14:35:32+0000 uid 0 xlated 160B jited 272B memlock 4096B map_ids 29 btf_id 124 pids hello-tail.py(3590) 121: raw_tracepoint name ignore_opcode tag a04f5eef06a7f555 gpl loaded_at 2023-01-05T14:35:32+0000 uid 0 xlated 16B jited 72B memlock 4096B btf_id 124 pids hello-tail.py(3590) 122: raw_tracepoint name hello_exec tag 931f578bd09da154 gpl loaded_at 2023-01-05T14:35:32+0000 uid 0 xlated 112B jited 168B memlock 4096B btf_id 124 pids hello-tail.py(3590) 123: raw_tracepoint name hello_timer tag 6c3378ebb7d3a617 gpl loaded_at 2023-01-05T14:35:32+0000 uid 0 xlated 336B jited 356B memlock 4096B btf_id 124 pids hello-tail.py(3590)您还可以使用

bpftool prog dump xlated来查看字节码指令,并将其与“BPF 到 BPF 调用”节中的内容进行比较。 -

请谨慎对待此问题,最好只是思考为什么会发生这种情况,而不是尝试实际操作! 如果您从 XDP 程序返回

0值,这对应于XDP_ABORTED,告诉内核中止对此数据包的任何进一步处理。考虑到在 C 中,0通常表示成功,这可能看起来有些违反直觉,但事实就是如此。因此,如果您尝试修改程序以返回0并将其附加到虚拟机的eth0接口,则所有网络数据包都会被丢弃。如果您使用 SSH 连接到该机器,这将是非常不幸的,您可能需要重启机器才能重新获得访问权限!您可以在容器中运行该程序,以便将 XDP 程序附加到仅影响该容器的虚拟以太网接口,而不是整个虚拟机。在 https://github.com/lizrice/lb-from-scratch 上有一个示例。

越来越多的 eBPF 程序也开始使用 Rust 编写,因为 Rust 编译器支持将 eBPF 字节码作为目标。

有一些指令的操作会受到指令中其他字段值的“修改”。例如,在内核 5.12 中引入了一组原子指令,这些指令包括在 imm 字段中指定操作类型的算术操作(ADD、AND、OR、XOR)。

-g 标志被用来生成 BTF 信息,这对于 CO-RE eBPF 程序是必需的,我将在第 5 章进行介绍。

通常情况下,eBPF 程序可以加载到内核中而不必固定到文件位置——但对于 bpftool 来说,这并非可选项,它必须将加载的程序固定。这个原因在“BPF 程序和映射引用”一节中有进一步的解释。

启用 JIT 编译需要在内核中启用CONFIG_BPF_JIT配置选项,并且在运行时可以通过net.core.bpf_jit_enable sysctl设置启用或禁用 JIT 编译。关于不同芯片架构上的 JIT 支持的更多信息,请参阅文档。

这里,bss 代表 “block started by symbol”。

第 4 章 bpf()系统调用

正如您在第 1 章中所看到的,当用户空间应用程序希望内核代表它们执行某项操作时,它们会使用系统调用 API 发出请求。因此,如果用户空间应用程序想将 eBPF 程序加载到内核中,必然会涉及到一些系统调用。实际上,这个系统调用是 bpf()。在本章中,我将向您展示如何使用它来加载 eBPF 程序和映射并与之交互。

值得注意的是,运行在内核中的 eBPF 代码并不使用系统调用来访问映射。系统调用接口仅供用户空间应用程序使用。相反,eBPF 程序使用辅助函数来读写映射;在前两章中,您已经看到了这方面的例子。

如果您自己去编写 eBPF 程序,很可能不会直接调用这些 bpf() 系统调用。我将在书中稍后讨论一些提供更高级抽象的库,使其更容易使用。尽管如此,这些抽象通常与您在本章中看到的底层系统调用命令直接对应。无论您使用什么库,都需要掌握底层操作——加载程序、创建和访问映射等,这些操作将在本章中介绍。

在向您展示 bpf() 系统调用的示例之前,让我们先看看 bpf() 的手册页上的说明,即 bpf() 用于“对扩展的 BPF 映射或程序执行命令”。它还告诉我们,bpf() 的函数签名如下:

int bpf(int cmd, union bpf_attr *attr, unsigned int size);

bpf() 的第一个参数 cmd 指定要执行的命令。bpf() 系统调用不仅执行一个操作——可以使用许多不同的命令来操作 eBPF 程序和映射。图 4-1 展示了一些用户空间代码可能用来加载 eBPF 程序、创建映射、将程序附加到事件以及访问映射中键值对的常见命令。

%E7%B3%BB%E7%BB%9F%E8%B0%83%E7%94%A8/figure-4-1.png)

图 4-1. 用户空间程序使用系统调用与内核中的 eBPF 程序和映射进行交互

bpf() 系统调用的 attr 参数保存用于指定命令参数的必要数据,而 size 表示 attr 中数据的字节数。

您已经在第 1 章中遇到过 strace,当时我用它来展示用户空间代码如何通过系统调用 API 发出许多请求。在本章中,我将用它来演示 bpf() 系统调用的使用。strace 的输出包括每个系统调用的参数,但为了避免本章示例输出过于繁杂,除非 attr 参数中特别有趣的细节,否则我会省略大量细节。

note

您可以在 github.com/lizrice/learning-ebpf 找到代码以及运行环境的设置说明。本章的代码位于 chapter4 目录中。

在这个例子中,我将使用一个名为 hello-buffer-config.py 的 BCC 程序,该程序基于您在第 2 章中看到的示例构建。与 hello-buffer.py 示例类似,该程序每次运行时都会向 perf 缓冲区发送消息,将关于 execve() 系统调用事件的信息从内核传递到用户空间。此版本的新功能是,它允许为每个用户 ID 配置不同的消息。

以下是 eBPF 源代码:

struct user_msg_t { // 1

char message[12];

};

BPF_HASH(config, u32, struct user_msg_t); // 2

BPF_PERF_OUTPUT(output); // 3

struct data_t { // 4

int pid;

int uid;

char command[16];

char message[12];

};

int hello(void *ctx) { // 5

struct data_t data = {};

struct user_msg_t *p;

char message[12] = "Hello World";

data.pid = bpf_get_current_pid_tgid() >> 32;

data.uid = bpf_get_current_uid_gid() & 0xFFFFFFFF;

bpf_get_current_comm(&data.command, sizeof(data.command));

p = config.lookup(&data.uid); // 6

if (p != 0) {

bpf_probe_read_kernel(&data.message, sizeof(data.message), p->message);

} else {

bpf_probe_read_kernel(&data.message, sizeof(data.message), message);

}

output.perf_submit(ctx, &data, sizeof(data));

return 0;

}

- 这行代码定义了一个用于保存 12 字符长度消息的结构体

user_msg_t。 - BCC 宏

BPF_HASH用于定义一个名为config的哈希表映射。它将存储类型为user_msg_t的值,键为类型u32,该类型适用于用户 ID。(如果未指定键和值的类型,BCC 会默认将两者设置为u64。) perf缓冲区输出的定义与第 2 章完全相同。您可以将任意数据提交到缓冲区,因此无需在此处指定任何数据类型...- ...尽管实际上在此示例中程序始终提交一个

data_t结构。这与第 2 章的示例没有变化。 - 其余的大部分 eBPF 程序与您之前看到的

hello()版本相比没有变化。 - 唯一的区别是,代码使用辅助函数获取用户 ID 后,在

config哈希映射中查找以该用户 ID 为键的条目。如果找到匹配的条目,值中包含的消息将替代默认的“Hello World”。

Python 代码增加了两行:

b["config"][ct.c_int(0)] = ct.create_string_buffer(b"Hey root!")

b["config"][ct.c_int(501)] = ct.create_string_buffer(b"Hi user 501!")

它们在 config 哈希表中定义了用户 ID 0 和 501 的消息,它们对应于该虚拟机上的 root 用户 ID 和我的用户 ID。此代码使用 Python 的 ctypes 包来确保键和值的类型与 C 语言中 user_msg_t 的定义相同。

以下是这个示例的一些输出说明,以及我在第二个终端中运行的命令:

Terminal 1 Terminal 2

$ ./hello-buffer-config.py

37926 501 bash Hi user 501! ls

37927 501 bash Hi user 501! sudo ls

37929 0 sudo Hey root!

37931 501 bash Hi user 501! sudo -u daemon ls

37933 1 sudo Hello World

现在您已经了解了该程序的功能,接下来,我想向您展示它运行时使用的 bpf() 系统调用。我将使用 strace 重新运行该程序,并指定 -e bpf 来表示我只对查看 bpf() 系统调用感兴趣:

$ strace -e bpf ./hello-buffer-config.py

如果您亲自尝试,将看到几个调用此系统调用的实例。对于每个实例,您将看到指示 bpf() 系统调用应执行什么操作的命令。大致内容如下:

bpf(BPF_BTF_LOAD, ...) = 3

bpf(BPF_MAP_CREATE, {map_type=BPF_MAP_TYPE_PERF_EVENT_ARRAY...) = 4

bpf(BPF_MAP_CREATE, {map_type=BPF_MAP_TYPE_HASH...) = 5

bpf(BPF_PROG_LOAD, {prog_type=BPF_PROG_TYPE_KPROBE,...prog_name="hello",...) = 6

bpf(BPF_MAP_UPDATE_ELEM, ...}

...

让我们逐一分析这些调用。您和我都没有无限的耐心,因此我不会讨论每次调用的每个参数!我将重点关注我认为有助于讲述用户空间程序与 eBPF 程序交互时所发生事情的部分。

加载 BTF 数据

我看到的第一个 bpf() 调用如下:

bpf(BPF_BTF_LOAD, {btf="\237\353\1\0...}, 128) = 3

在此输出中,您看到的命令是 BPF_BTF_LOAD。这是(至少在撰写本文时)在内核源代码中最全面记录的一组有效命令之一1。

如果您使用的是相对较旧的 Linux 内核,可能不会看到带有此命令的调用,因为它与 BTF2(BPF Type Fromat,BPF 类型格式)有关。BTF 允许 eBPF 程序在不同的内核版本之间移植,这样您就可以在一台机器上编译程序,并在另一台可能使用不同内核版本并因此具有不同内核数据结构的机器上使用它。我将在第 5 章中对此进行更详细的讨论。

这次对 bpf() 的调用将一块 BTF 数据加载到内核中,并且 bpf() 系统调用的返回值(在我的示例中为 3)是引用该数据的文件描述符。

note

文件描述符是打开文件(或类文件对象)的标识符。如果您打开一个文件(使用 open() 或 openat() 系统调用),返回值是一个文件描述符,然后将其作为参数传递给其他系统调用,如 read() 或 write(),以执行对该文件的操作。这里的数据块并不完全是文件,但被赋予一个文件描述符作为标识符,可以用于以后的相关操作。

创建映射

接下来的 bpf() 调用创建了 perf 缓冲区映射 output:

bpf(BPF_MAP_CREATE, {map_type=BPF_MAP_TYPE_PERF_EVENT_ARRAY, , key_size=4,

value_size=4, max_entries=4, ... map_name="output", ...}, 128) = 4

您可以从命令名称 BPF_MAP_CREATE 推测出此调用用于创建 eBPF 映射。可以看到,这个映射的类型是 PERF_EVENT_ARRAY,名为 output。在这个 perf 事件映射中,键和值都是 4 字节长。映射中最多可以存放 4 对键值对,这由 max_entries 字段定义;我将在本章稍后解释为什么这个映射有四个条目。返回值 4 是用于用户空间代码访问 output 映射的文件描述符。

输出中的下一个 bpf() 系统调用创建了 config 映射:

bpf(BPF_MAP_CREATE, {map_type=BPF_MAP_TYPE_HASH, key_size=4, value_size=12,

max_entries=10240... map_name="config", ...btf_fd=3,...}, 128) = 5

这个映射被定义为哈希表映射,键为 4 字节长(对应于可以用来保存用户 ID 的 32 位整数),值为 12 字节长(与 msg_t 结构的长度相匹配)。我没有指定表的大小,因此它使用了 BCC 的默认大小,拥有 10,240 个条目。

这个 bpf() 系统调用也返回了一个文件描述符 5,该描述符将用于在将来的系统调用中引用这个 config 映射。

您还可以看到字段 btf_fd=3,它告诉内核使用之前获得的 BTF 文件描述符 3。正如您将在第 5 章中看到的,BTF 信息描述了数据结构的布局,将其包含在映射定义中意味着拥有关于映射中使用的键和值类型布局的信息。这被 bpftool 等工具用于对映射转储进行美化打印,使其更易于人们理解——您在第 3 章中看到了这方面的例子。

加载程序

到目前为止,您已经看到示例程序使用系统调用将 BTF 数据加载到内核中并创建了一些 eBPF 映射。接下来,它通过以下 bpf() 系统调用将 eBPF 程序加载到内核中:

bpf(BPF_PROG_LOAD, {prog_type=BPF_PROG_TYPE_KPROBE, insn_cnt=44,

insns=0xffffa836abe8, license="GPL", ... prog_name="hello", ...

expected_attach_type=BPF_CGROUP_INET_INGRESS, prog_btf_fd=3,...}, 128) = 6

这里有一些有趣的字段:

prog_type字段描述了程序类型,这里表示它将被附加到 kprobe。您将在第 7 章中了解更多关于程序类型的信息。insn_cnt字段表示“指令计数”。这是程序中的字节码指令的数量。- 构成这个 eBPF 程序的字节码指令在

insns字段指定的地址处的内存中保存。 - 这个程序被指定为 GPL 许可,以便它可以使用 GPL 许可的 BPF 辅助函数。

- 程序名称是

hello。 expected_attach_type为BPF_CGROUP_INET_INGRESS可能让人感到惊讶,因为它听起来像是与入站网络流量有关的东西,但您知道这个 eBPF 程序将要附加到 kprobe。实际上,expected_attach_type字段仅用于某些程序类型,而BPF_PROG_TYPE_KPROBE并不是其中之一。BPF_CGROUP_INET_INGRESS恰好是 BPF 附加类型列表中的第一个3,因此它的值为 0。prog_btf_fd字段告诉内核先前加载的 BTF 数据中的哪个块与此程序一起使用。这里的值3对应于您从BPF_BTF_LOAD系统调用返回的文件描述符(与用于config映射的 BTF 数据块相同)。

如果程序验证失败(我将在第 6 章中讨论),此系统调用将返回负值,但在这里您可以看到它返回文件描述符 6。 回顾一下,此时文件描述符的含义如表 4-1 所示。

如果程序验证失败(我将在第 6 章讨论),这个系统调用将返回一个负值,但在这里您可以看到它返回了文件描述符 6。概括来说,此时文件描述符的含义如表 4-1 所示。

表 4-1. 在运行 hello-buffer-config.py 时加载程序后的文件描述符

| 文件描述符 | 代表含义 |

|---|---|

| 3 | BTF 数据 |

| 4 | perf 缓冲区映射 output |

| 5 | 哈希表映射 config |

| 6 | eBPF 程序 hello |

从用户空间修改映射

您已经在 Python 用户空间源代码中看到了为用户 ID 为 0 的 root 用户和 ID 为 501 的用户配置特殊消息的代码行:

b["config"][ct.c_int(0)] = ct.create_string_buffer(b"Hey root!")

b["config"][ct.c_int(501)] = ct.create_string_buffer(b"Hi user 501!")

您可以看到这些条目被通过如下系统调用,在映射中定义:

bpf(BPF_MAP_UPDATE_ELEM, {map_fd=5, key=0xffffa7842490, value=0xffffa7a2b410, flags=BPF_ANY}, 128) = 0

BPF_MAP_UPDATE_ELEM 命令用于更新映射中的键值对。BPF_ANY 标志表示如果该键在映射中不存在,则应创建它。这里有两次这样的调用,分别对应于为两个不同用户 ID 配置的两个条目。

map_fd 字段用于标识正在操作的映射。您可以在这看到它是 5,这是先前创建 config 映射时返回的文件描述符。

文件描述符是由内核为特定进程分配的,所以这个值 5 只对该特定用户空间进程有效,在该进程中运行着这个 Python 程序。然而,多个用户空间程序(以及内核中的多个 eBPF 程序)都可以访问相同的映射。两个访问内核中相同映射的用户空间程序可能被分配不同的文件描述符值;同样,两个用户空间程序可能对于完全不同的映射具有相同的文件描述符值。

键和值都是指针,所以无法从 strace 输出中判断键或值的数值。不过,您可以使用 bpftool 查看映射的内容,并看到类似这样的信息:

$ bpftool map dump name config

[{

"key": 0,

"value": {

"message": "Hey root!"

}

},{

"key": 501,

"value": {

"message": "Hi user 501!"

}

}

]

bpftool 是怎么知道如何格式化输出的呢?例如,它如何知道该值是一个结构体,其中包含一个名为 message 的字段,其中包含一个字符串?答案是它使用定义此 map 的 BPF_MAP_CREATE 系统调用中包含的 BTF 信息中的定义。您将在下一章中看到有关 BTF 如何传达此信息的更多详细信息。

bpftool 是怎么知道如何格式化这个输出的?例如,它是如何知道值是一个包含名为 message 字段的字符串的结构体?答案在于它使用了在定义这个映射时通过BPF_MAP_CREATE系统调用包含的 BTF(BPF Type Format)信息。在下一章中,您将了解更多关于 BTF 如何传达这些信息的细节。

您现在已经看到了用户空间如何与内核交互以加载程序和映射,并更新映射中的信息。在您到目前为止看到的系统调用序列中,程序尚未附加到任何事件。这个步骤必须执行,否则程序将永远不会被触发。

需要注意的是,不同类型的 eBPF 程序会以多种不同的方式附加到不同的事件上!在本章稍后,我将向您展示在本例中如何使用系统调用附加到 kprobe 事件上,而这个过程不涉及bpf()调用。相比之下,在本章末尾的练习中,我会展示另一个例子,说明如何通过bpf()系统调用将程序附加到原始跟踪点(raw tracepoint)事件上。

在我们深入了解这些细节之前,我想讨论当您停止运行程序时会发生什么。您会发现程序和映射会自动卸载,这是因为内核使用*引用计数(reference counts)*来跟踪它们。

BPF 程序和映射引用

您知道,使用 bpf() 系统调用将 BPF 程序加载到内核会返回一个文件描述符。在内核中,这个文件描述符是对程序的引用。发起系统调用的用户空间进程拥有这个文件描述符;当该进程退出时,文件描述符会被释放,程序的引用计数会减少。当 BPF 程序不再有任何引用时,内核会移除该程序。

当您将程序*固定(pin)*到文件系统时,会创建一个额外的引用。

固定(pinning)

您已经在第 3 章中看到了固定操作,使用了以下命令:

bpftool prog load hello.bpf.o /sys/fs/bpf/hello

note

这些固定的对象并不是持久化到磁盘上的真实文件。它们是在伪文件系统上创建的,这个文件系统的行为类似于具有目录和文件的常规基于磁盘的文件系统。但它们保存在内存中,这意味着在系统重启后它们将不会保留在原位置。

如果 bpftool 允许您加载程序而不固定它,那将毫无意义,因为当 bpftool 退出时文件描述符会被释放,并且如果引用为零,程序就会被删除,所以不会实现任何有用的功能。但是将程序固定到文件系统意味着程序有了一个额外的引用,所以程序在命令完成后仍然保持加载状态。

当 BPF 程序附加到触发它的钩子时,引用计数也会增加。这些引用计数的行为取决于 BPF 程序的类型。您将在第 7 章中了解更多关于这些程序类型的信息,但有一些与追踪相关(如 kprobes 和 tracepoints)并且总是与用户空间进程相关联;对于这些类型的 eBPF 程序,当该进程退出时,内核的引用计数会减少。在网络协议栈或 cgroups(“control group,控制组”的缩写)中附加的程序不与任何用户空间进程关联,因此即使加载它们的用户空间程序退出了,它们也会保持原位。当使用 ip link 命令加载 XDP 程序时,您已经看到了这样一个例子:

ip link set dev eth0 xdp obj hello.bpf.o sec xdp

ip 命令已经完成,没有定义固定的位置,但尽管如此,bpftool 会现实 XDP 程序已经加载到内核中:

$ bpftool prog list

…

1255: xdp name hello tag 9d0e949f89f1a82c gpl

loaded_at 2022-11-01T19:21:14+0000 uid 0

xlated 48B jited 108B memlock 4096B map_ids 612

这个程序的引用计数不为零,因为在 ip link 命令完成后 XDP 钩子的附加仍然存在。

eBPF 映射也有引用计数,当它们的引用计数降到零时,也会被清理。每个使用映射的 eBPF 程序都会增加计数,用户空间程序对映射持有的文件描述符也会增加计数。

可能的情况是,eBPF 程序的源代码可能会定义一个程序实际上并不引用的映射。假设您想要存储关于程序的一些元数据;您可以将其定义为一个全局变量,正如您在上一章中看到的,这些信息被存储在映射中。如果 eBPF 程序不对该映射执行任何操作,那么程序到映射之间不会自动产生一个引用计数。有一个 BPF(BPF_PROG_BIND_MAP)系统调用,用于将映射与程序关联起来,以便在用户空间加载程序退出并且不再持有映射的文件描述符引用时,映射不会被立即清理。

映射也可以被固定到文件系统中,用户空间程序可以通过映射的路径来获取对映射的访问。

note

Alexei Starovoitov 在他的博客文章“BPF 对象的生命周期”中很好地描述了 BPF 引用计数器和文件描述符。

创建 BPF 程序引用的另一种方式是使用 BPF 链接(link)。

BPF 链接(BPF Links)

BPF 链接为 eBPF 程序与其附加的事件之间提供了一个抽象层。BPF 链接本身可以被固定到文件系统中,这为程序创建了另一个引用。这意味着将程序加载到内核的用户空间进程可以终止,而程序仍然被加载。用户空间加载程序的文件描述符被释放,减少了程序的引用计数,但由于 BPF 链接的存在,引用计数将不为零。

如果您按照本章结尾的练习操作,您将有机会看到 BPF 链接的实际应用。现在,让我们回到 hello-buffer-config.py 使用的 bpf() 系统调用序列。

eBPF 中涉及的其他系统调用

回顾一下,到目前为止,您已经看到了 bpf() 系统调用,它将 BTF 数据、程序和映射,以及映射中的数据添加到内核。 strace 输出中接下来显示的内容与设置 perf 缓冲区有关。

note

本章其余部分将深入探讨在使用 perf 缓冲区、环形缓冲区、kprobes 和映射迭代时涉及的系统调用序列。并非所有的 eBPF 程序都需要做这些事情,所以如果您赶时间或者觉得内容过于详细,可以跳到本章总结。我不会介意的!

初始化 perf 缓冲区

您已经看到了 bpf(BPF_MAP_UPDATE_ELEM) 调用,它们向config 映射中添加条目。接下来,输出显示了一些类似以下格式的调用:

bpf(BPF_MAP_UPDATE_ELEM, {map_fd=4, key=0xffffa7842490, value=0xffffa7a2b410, flags=BPF_ANY}, 128) = 0

这些调用看起来与定义 config 映射条目的调用非常相似,只是在这种情况下,映射的文件描述符是 4,它代表 output perf 缓冲区映射。

与之前一样,键和值是指针,因此无法从 strace 输出中判断键或值的数值。我看到这个系统调用重复了四次,所有参数的值都相同,但无法知道在每次调用之间指针的值是否发生了变化。通过观察这些 BPF_MAP_UPDATE_ELEM bpf() 调用,我们对缓冲区是如何设置和使用有了一些疑问:

- 为什么有四次对

BPF_MAP_UPDATE_ELEM的调用?这与output映射创建时具有最大四个条目的事实有关吗? - 在这四个

BPF_MAP_UPDATE_ELEM实例之后,strace输出中没有出现更多的bpf()系统调用。这可能看起来有点奇怪,因为映射的存在是为了让 eBPF 程序每次被触发时都能写入数据,而您已经看到用户空间代码显示的数据。这些数据显然不是通过bpf()系统调用从映射中检索的,那么它是如何获取的呢?

您还没有看到任何证据表明 eBPF 程序是如何附加到触发它的 kprobe 事件的。为了解释所有这些问题,我需要 strace 在运行此示例时显示更多系统调用,如下所示:

$ strace -e bpf,perf_event_open,ioctl,ppoll ./hello-buffer-config.py

为了简洁起见,我将忽略与这个示例的 eBPF 功能无关的 ioctl() 调用。

附加到 Kprobe 事件

您已经看到,在 eBPF 程序 hello 加载到内核后,文件描述符 6 被分配来表示它。要将 eBPF 程序附加到一个事件上,您还需要一个代表该特定事件的文件描述符。以下是strace输出中的一行,显示了为execve() kprobe 创建文件描述符的过程:

perf_event_open({type=0x6 /* PERF_TYPE_??? */, ...},...) = 7

根据perf_event_open()系统调用的手册,它“创建了一个文件描述符,允许测量性能信息”。从输出可以看到,strace无法解释值为 6 的类型参数,但如果进一步查看手册,您会发现 Linux 如何支持性能测量单元(Performance Measurement Unit)的动态类型:

...在 /sys/bus/event_source/devices 下,每个 PMU 实例都有一个子目录。在每个子目录中都有一个类型文件,其内容是一个整数,可用于类型字段。

果然,如果您查看该目录,您会发现一个 kprobe/type 文件:

$ cat /sys/bus/event_source/devices/kprobe/type

6

从这里可以看到,对 perf_event_open() 的调用将类型设置为 6,表示这是一个 kprobe 类型的 perf 事件。

不幸的是,strace 没有输出能够明确显示 kprobe 附加到 execve() 系统调用的详细信息,但我希望这里的证据足以使您相信返回的文件描述符所代表的就是这个。

perf_event_open() 的返回码是 7,这代表了 kprobe 的 perf 事件的文件描述符,并且您知道文件描述符 6 代表的是 eBPF 程序 hello。perf_event_open() 的手册还解释了如何使用 ioctl() 在这两者之间创建关联:

PERF_EVENT_IOC_SET_BPF[...] 允许将 Berkeley Packet Filter (BPF)程序附加到现有的 kprobe 跟踪点事件。参数是之前由bpf (2)系统调用创建的 BPF 程序文件描述符。

这解释了您将在 strace 输出中看到的以下 ioctl() 系统调用,其中的参数指的是两个文件描述符:

ioctl(7, PERF_EVENT_IOC_SET_BPF, 6) = 0

还有一个 ioctl() 调用用来启动 kprobe 事件:

ioctl(7, PERF_EVENT_IOC_ENABLE, 0) = 0

有了这些,每当在这个机器上运行 execue() 时,就会触发 eBPF 程序。

设置和读取 Perf 事件

我已经提到,我看到了四个与 output perf 缓冲区相关的 bpf(BPF_MAP_UPDATE_ELEM) 调用。随着额外系统调用的跟踪,strace 输出显示了四个序列,如下所示:

perf_event_open({type=PERF_TYPE_SOFTWARE, size=0 /* PERF_ATTR_SIZE_??? */,

config=PERF_COUNT_SW_BPF_OUTPUT, ...}, -1, X, -1, PERF_FLAG_FD_CLOEXEC) = Y

ioctl(Y, PERF_EVENT_IOC_ENABLE, 0) = 0

bpf(BPF_MAP_UPDATE_ELEM, {map_fd=4, key=0xffffa7842490, value=0xffffa7a2b410, flags=BPF_ANY}, 128) = 0

在上面的输出中,我使用 X 的位置表示值 0、1、2 和 3 。查阅 perf_event_open() 系统调用的手册,您会看到这是 cpu,它前面的字段是 pid 或进程 ID。手册页中写道:

当 pid == -1 并且 cpu >= 0 时,会测量指定 CPU 上的所有进程/线程。

这一序列发生四次对应于我的笔记本电脑有四个 CPU 核心。这终于解释了为什么 "output" perf 缓冲区映射中有四个条目:每个 CPU 核心一个。这也解释了映射类型名称 BPF_MAP_TYPE_PERF_EVENT_ARRAY 中的 “array” 部分,因为该映射不仅仅代表一个 perf 环形缓冲区,而是一个缓冲区数组,每个核心都有一个。

如果您编写 eBPF 程序,无需担心诸如处理核心数量之类的细节,因为这会由第 10 章讨论的 eBPF 库为您处理,但我认为这是当您在此程序上使用 strace 时看到的系统调用中的一个有趣方面。

每个 perf_event_open() 调用都会返回一个文件描述符,我用 Y 表示这些值;这些值分别是 8、9、10 和 11。ioctl() 系统调用为每个文件描述符启用 perf 输出。BPF_MAP_UPDATE_ELEM bpf() 系统调用将映射条目设置为指向每个 CPU 核心的 perf 环形缓冲区,以指示它提交数据的位置。

然后,用户空间代码可以在所有这四个输出流文件描述符上使用 ppoll(),以便无论哪个核心恰好运行给定 execue() kprobe 事件的 eBPF 程序 hello,它都可以获得数据输出。以下是 ppoll() 的系统调用:

ppoll([{fd=8, events=POLLIN}, {fd=9, events=POLLIN}, {fd=10, events=POLLIN},

{fd=11, events=POLLIN}], 4, NULL, NULL, 0) = 1 ([{fd=8, revents=POLLIN}])

如您亲自尝试运行示例程序,您将会看到,这些 ppoll() 调用会阻塞,直到有一个文件描述符中有东西可读。在触发 execve() 之前,您不会在屏幕上看到返回值,而触发 execve() 后,eBPF 程序会写入数据,用户空间通过这个 ppoll() 调用检索这些数据。

在第 2 章中我提到,如果您有一个版本为 5.8 或以上的内核,BPF 环形缓冲区现在比 perf 缓冲区更受欢迎4。让我们看一下同一个示例代码的修改版,它使用了环形缓冲区。

环形缓冲区

正如内核文档中所讨论的,环形缓冲区之所以优于 perf 缓冲区,部分原因是性能优化,同时还能确保数据顺序得以保留,即便数据是由不同的 CPU 核心提交的。所有核心共享同一个缓冲区。

将 hello-buffer-config.py 转换为使用环形缓冲区不需要太多更改。在附带的 GitHub 仓库中,您会在 chapter4/hello-ring-buffer-config.py 中找到这个示例。表 4-2 展示了差异。

表 4-2. 使用 perf 缓冲区和环形缓冲区的示例 BCC 代码之间的差异

| hello-buffer-config.py | hello-ring-buffer-config.py |

|---|---|

BPF_PERF_OUTPUT(output); | BPF_RINGBUF_OUTPUT(output, 1); |

output.perf_submit(ctx, &data, sizeof(data)); | output.ringbuf_output(&data, sizeof(data), 0); |

b["output"].open_perf_buffer(print_event) | b["output"].open_ring_buffer(print_event) |

b.perf_buffer_poll() | b.ring_buffer_poll() |

如您所预期的,由于这些更改仅与输出缓冲区有关,因此与加载程序、config 映射以及将程序附加到 kprobe 事件相关的系统调用都保持不变。

创建 output 环形缓冲区映射的 bpf() 系统调用如下所示:

bpf(BPF_MAP_CREATE, {map_type=BPF_MAP_TYPE_RINGBUF, key_size=0, value_size=0,

max_entries=4096, ... map_name="output", ...}, 128) = 4

strace 输出的主要区别在于,没有观察到在设置 perf 缓冲区时出现的四个不同的 perf_event_open()、ioctl() 和 bpf(BPF_MAP_UPDATE_ELEM) 系统调用序列。对于环形缓冲区,只有一个文件描述符在所有 CPU 核心之间共享。

在撰写本文时,BCC 正在使用我在前面展示的 ppoll 机制来处理 perf 缓冲区,但它使用较新的 epoll 机制来等待环形缓冲区的数据。让我们利用这个机会来了解 ppoll 和 epoll 之间的区别。

在 perf 缓冲区示例中,我展示了 hello-buffer-config.py 生成的一个 ppoll() 系统调用,如下所示:

ppoll([{fd=8, events=POLLIN}, {fd=9, events=POLLIN}, {fd=10, events=POLLIN},

{fd=11, events=POLLIN}], 4, NULL, NULL, 0) = 1 ([{fd=8, revents=POLLIN}])

注意,这传递了文件描述符集 8、9、10 和 11,用户空间进程希望从中检索数据。每次这个轮询事件返回数据时,都必须再次调用 ppoll() 来设置相同的文件描述符集。使用 epoll 时,文件描述符集由内核对象管理。

您可以在以下序列中看到这一点,当 hello-ring-buffer-config.py 在设置对 output 环形缓冲区的访问时,会进行一系列与 epoll 相关的系统调用。

首先,用户空间程序请求在内核中创建一个新的 epoll 实例:

epoll_create1(EPOLL_CLOEXEC) = 8

这返回文件描述符 8。然后有一个对 epoll_ctl() 的调用,告诉内核将文件描述符 4(output 缓冲区)添加到 epoll 实例中的文件描述符集中:

epoll_ctl(8, EPOLL_CTL_ADD, 4, {events=EPOLLIN, data={u32=0, u64=0}}) = 0

用户空间程序使用 epoll_pwait() 等待,直到环形缓冲区中有数据可用。此调用仅在数据可用时返回:

epoll_pwait(8, [{events=EPOLLIN, data={u32=0, u64=0}}], 1, -1, NULL, 8) = 1

当然,如果您正在使用 BCC(或 libbpf,或本书后面将要介绍的任何其他库)之类的框架编写代码,您实际上不需要了解这些底层细节,比如您的用户空间应用程序是如何通过 perf 缓冲区或环形缓冲区从内核获取信息的。我希望您对了解这些工作原理的幕后一瞥感到有趣。

然而,您很可能会发现自己编写了从用户空间访问映射的代码,看看如何实现这一点的示例可能会对您有所帮助。在本章前面,我使用 bpftool 检查了 config 映射的内容。由于这是一个在用户空间运行的工具,让我们使用 strace 来查看它为了检索这些信息而进行的系统调用。

从映射中读取信息

下面的命令显示了 bpftool 在读取 config 映射内容时进行的 bpf() 系统调用的摘录:

$ strace -e bpf bpftool map dump name config

如您将看到的,该序列主要由两个步骤组成:

- 遍历所有映射,寻找名为

config的映射。 - 如果找到匹配的映射,遍历该映射中的所有元素。

查找映射

输出以一系列重复的类似调用开始,因为 bpftool 会遍历所有映射,寻找 config:

bpf(BPF_MAP_GET_NEXT_ID, {start_id=0,...}, 12) = 0 # 1

bpf(BPF_MAP_GET_FD_BY_ID, {map_id=48...}, 12) = 3 # 2

bpf(BPF_OBJ_GET_INFO_BY_FD, {info={bpf_fd=3, ...}}, 16) = 0 # 3

bpf(BPF_MAP_GET_NEXT_ID, {start_id=48, ...}, 12) = 0 # 4

bpf(BPF_MAP_GET_FD_BY_ID, {map_id=116, ...}, 12) = 3

bpf(BPF_OBJ_GET_INFO_BY_FD, {info={bpf_fd=3...}}, 16) = 0

BPF_MAP_GET_NEXT_ID获取指定start_id后的下一个映射的 ID。BPF_MAP_GET_FD_BY_ID返回指定映射 ID 的文件描述符。BPF_OBJ_GET_INFO_BY_FD检索文件描述符所引用对象(在本例中为映射)的信息。此信息包括名称,以便bpftool可以检查这是否是它正在查找的映射。- 重复该序列,获取步骤 1 中映射之后的下一张映射 ID。

对于每个加载到内核中的映射,都有一组这三个系统调用,并且您还会看到 start_id 和 map_id 使用的值与这些映射的 ID 匹配。当没有更多映射可供查看时,重复模式结束,此时 BPF_MAP_GET_NEXT_ID 返回一个 ENOENT 值,如下所示:

bpf(BPF_MAP_GET_NEXT_ID, {start_id=133,...}, 12) = -1 ENOENT (No such file or directory)

如果找到匹配的映射,bpftool 会保存其文件描述符,以便可以从该映射中读取元素。

读取映射中的元素

此时,bpftool 对要读取的映射有一个文件描述符引用。让我们看看读取这些信息的系统调用序列:

bpf(BPF_MAP_GET_NEXT_KEY, {map_fd=3, key=NULL, # 1

next_key=0xaaaaf7a63960}, 24) = 0

bpf(BPF_MAP_LOOKUP_ELEM, {map_fd=3, key=0xaaaaf7a63960, # 2

value=0xaaaaf7a63980, flags=BPF_ANY}, 32) = 0

[{ # 3

"key": 0,

"value": {

"message": "Hey root!"

}

bpf(BPF_MAP_GET_NEXT_KEY, {map_fd=3, key=0xaaaaf7a63960, # 4

next_key=0xaaaaf7a63960}, 24) = 0

bpf(BPF_MAP_LOOKUP_ELEM, {map_fd=3, key=0xaaaaf7a63960,

value=0xaaaaf7a63980, flags=BPF_ANY}, 32) = 0

},{

"key": 501,

"value": {

"message": "Hi user 501!"

}

bpf(BPF_MAP_GET_NEXT_KEY, {map_fd=3, key=0xaaaaf7a63960, # 5

next_key=0xaaaaf7a63960}, 24) = -1 ENOENT (No such file or directory)

} # 6

]

+++ exited with 0 +++

- 首先,应用程序需要在映射中找到一个有效的键。它通过

bpf()系统调用的BPF_MAP_GET_NEXT_KEY来实现这一点。key参数是指向键的指针,系统调用将返回这个键之后的下一个有效键。通过传入一个 NULL 指针,应用程序请求映射中的第一个有效键。内核将键写入由next_key指针指向的位置。 - 给定一个键,应用程序请求关联的值,该值将被写入由

value指向的内存位置。 - 此时,

bpftool获得了第一个键值对的内容,并将该信息写入屏幕。 - 这里,

bpftool移动到映射中的下一个键,获取它的值,并将这个键值对写到屏幕上。 - 下一次调用

BPF_MAP_GET_NEXT_KEY返回ENOENT,表示映射中没有更多的条目。 - 此处,

bpftool最终确定屏幕上的输出并退出。

请注意,此处 bpftool 被分配了文件描述符 3 ,这对应于 config 映射。这与 hello-buffer-config.py 使用文件描述符 4 引用的是同一个映射。正如我之前提到的,文件描述符是特定于进程的。

对 bpftool 行为的分析展示了用户空间程序如何遍历可用的映射以及存储在映射中的键值对。

总结

在这一章中,您看到了用户空间代码如何使用 bpf() 系统调用加载 eBPF 程序和映射。您看到了使用 BPF_PROG_LOAD 和 BPF_MAP_CREATE 命令创建程序和映射。

您了解到,内核会跟踪对 eBPF 程序和映射的引用次数,并在引用计数降到零时释放它们。您还了解了,将 BPF 对象固定到文件系统以及使用 BPF 链接创建额外引用的概念。

您看到了一个示例,演示了如何使用 BPF_MAP_UPDATE_ELEM 从用户空间在映射中创建条目。还有类似的命令——BPF_MAP_LOOKUP_ELEM 和 BPF_MAP_DELETE_ELEM 用于从映射中检索和删除值。还有一个命令 BPF_MAP_GET_NEXT_KEY,用于查找映射中存在的下一个键。您可以使用它遍历所有有效条目。

您看到了用户空间程序使用 perf_event_open() 和 ioctl() 将 eBPF 程序附加到 kprobe 事件的示例。对于其他类型的 eBPF 程序,附加方法可能非常不同,其中一些甚至使用 bpf() 系统调用。例如,有一个 bpf(BPF_PROG_ATTACH) 系统调用可以用来附加 cgroup 程序,而 bpf(BPF_RAW_TRACEPOINT_OPEN) 用于原始跟踪点(参见本章末尾的练习 5)。

我还演示了如何使用 BPF_MAP_GET_NEXT_ID、BPF_MAP_GET_FD_BY_ID 和 BPF_OBJ_GET_INFO_BY_FD 来定位内核持有的映射(和其他)对象。

本章中还有一些 bpf() 命令没有涉及,但是您在这里看到的内容足以获得一个很好的全局视图了。

您还看到了一些 BTF 数据被加载到内核中,我提到 bpftool 使用这些信息来理解数据结构的格式,以便能够漂亮地打印它们。我还没有解释 BTF 数据的样子,或者它是如何用来使 eBPF 程序跨内核版本移植的。这些内容将在下一章中介绍。

练习

如果您想进一步探索 bpf() 系统调用,可以尝试以下几件事情:

-

确认从

BPF_PROG_LOAD系统调用中获取的insn_cnt字段与使用bpftool转储该程序翻译后的 eBPF 字节码时输出的指令数量相匹配。(这在bpf()系统调用的手册上有记录) -

运行示例程序的两个实例,以便有两个名为

config的映射。如果您运行bpftool map dump name config,输出将包括关于两个不同映射及其内容的信息。在strace下运行此命令,并跟踪系统调用输出中的不同文件描述符的使用。您能否看到它在哪里检索关于映射的信息,以及它在哪里检索存储在其中的键值对? -

在运行示例程序时,使用

bpftool map update修改config映射。使用sudo -u username来检查这些配置更改是否被 eBPF 程序采取。 -

当 hello-buffer-config.py 运行时,使用

bpftool将程序固定到 BPF 文件系统,如下所示:bpftool prog pin name hello /sys/fs/bpf/hi退出正在运行的程序,并使用

bpftool prog list检查hello程序是否仍然加载在内核中。您可以使用rm /sys/fs/bpf/hi删除固定来清理链接。 -

与附加到 kprobe 相比,在系统调用级别,附加到原始跟踪点要简单得多,因为它仅涉及一个

bpf()系统调用。尝试使用 BCC 的RAW_TRACEPOINT_PROBE宏,将 hello-buffer-config.py 转换为附加到sys_enter的原始跟踪点(如果您完成了第 2 章的练习,您已经有一个合适的程序可以使用)。在 Python 代码中,您不需要显式地附加程序,因为 BCC 会为您处理。在strace下运行此程序,您应该看到一个类似于以下的系统调用:bpf(BPF_RAW_TRACEPOINT_OPEN, {raw_tracepoint={name="sys_enter", prog_fd=6}}, 128) = 7内核中的跟踪点名为

sys_enter,文件描述符为6的 eBPF 程序正附加到它。从现在开始,每当内核中的执行到达该跟踪点时,都将触发该 eBPF 程序。 -

运行 BCC 的 libbpf 工具集中的 opensnoop 应用程序。此工具设置了一些 BPF 链接,您可以使用 bpftool 查看他们,如下所示:

$ bpftool link list 116: perf_event prog 1849 bpf_cookie 0 pids opensnoop(17711) 117: perf_event prog 1851 bpf_cookie 0 pids opensnoop(17711)确认程序 ID(在我的示例输出中为 1849 和 1851)与列出已加载 eBPF 程序的输出相匹配:

$ bpftool prog list ... 1849: tracepoint name tracepoint__syscalls__sys_enter_openat tag 8ee3432dcd98ffc3 gpl run_time_ns 95875 run_cnt 121 loaded_at 2023-01-08T15:49:54+0000 uid 0 xlated 240B jited 264B memlock 4096B map_ids 571,568 btf_id 710 pids opensnoop(17711) 1851: tracepoint name tracepoint__syscalls__sys_exit_openat tag 387291c2fb839ac6 gpl run_time_ns 8515669 run_cnt 120 loaded_at 2023-01-08T15:49:54+0000 uid 0 xlated 696B jited 744B memlock 4096B map_ids 568,571,569 btf_id 710 pids opensnoop(17711) -

在 opensnoop 运行时,尝试使用

bpftool link pin id 116 /sys/fs/bpf/mylink(使用您在bpftool link list输出中看到的链接 ID 之一)来固定其中一个链接。您应该看到,即使您终止了 opensnoop,链接和相应的程序仍然在内核中保持加载状态。 -

如果您跳转到第 5 章的示例代码,您会找到一个使用 libbpf 库编写的 hello-buffer-config.py 版本。这个库会自动为加载到内核中的程序设置一个 BPF 链接。使用

strace检查它进行的bpf()系统调用,并查看bpf(BPF_LINK_CREATE)系统调用。

如果您想查看完整的 BPF 命令集,可以参考 linux/bpf.h 头文件中的文档。

BTF 是在 5.1 内核中引入的,但在一些 Linux 发行版中已被回溯移植,正如这个讨论中所展示的那样。

这些定义在 linux/bpf.h 中的 bpf_attach_type 枚举类型中。

提醒您,要了解更多信息,请阅读 Andrii Nakryiko 的“BPF 环形缓冲区”博客文章。

第五章 CO-RE、BTF 和 Libbpf

在上一章中,您第一次遇到了 BTF(BPF Type Format,BPF 类型格式)。本章讨论它存在的原因以及如何使用它来使 eBPF 程序在不同版本的内核之间可移植。它是 BPF 一次编译、到处运行 (compile once-run everywhere,CO-RE) 方法的关键部分,该方法解决了 eBPF 程序在不同内核版本之间可移植的问题。

许多 eBPF 程序访问内核数据结构体,eBPF 程序员需要包含相关的 Linux 头文件,以便他们的 eBPF 代码可以正确定位这些数据结构体中的字段。然而,Linux 内核正在不断开发,这意味着不同内核版本之间的内部数据结构体可能会发生变化。如果您要将在一台机器上编译的 eBPF 目标文件加载到具有不同内核版本的机器上,则无法保证数据结构体相同。(严格来说,数据结构体定义来自内核头文件,您可以选择基于一组头文件进行编译,其中这组头文件可以与用于构建当前机器上运行的内核的头文件不同。为了正确工作(没有本章中描述的 CO-RE 机制),内核头必须与运行 eBPF 程序的目标机器上的内核兼容。)

CO-RE 方法在高效解决可移植性问题方面迈出了一大步。它允许 eBPF 程序包含编译时的数据结构体布局信息,并提供了一种机制,用于在目标机器上运行时,如果数据结构体布局不同,就调整字段的访问方式。只要程序不访问目标机器内核中根本不存在的字段或数据结构体,程序就可以在不同内核版本之间移植。

在我们深入探讨 CO-RE 如何工作的细节之前,让我们先看看 BCC 项目最初实现内核可移植性的方法,讨论一下为什么它如此受欢迎。

BCC 的可移植性方法

在第 2 章中,我使用 BCC 展示了 eBPF 程序的基本“Hello World”示例。 BCC 项目是第一个用于实现 eBPF 程序的流行项目,为用户空间和内核方面提供了一个框架,对于没有太多内核经验的程序员来说相对容易访问。为了解决跨内核的可移植性,BCC 采用了在运行时、在目标计算机上就地编译 eBPF 代码的方法。这种方法存在许多问题:

- 编译工具链需要安装在您希望运行代码的每台目标计算机上,内核头文件也需要安装(默认情况下并不总是存在)。

- 您必须等待编译完成才能启动该工具,这可能意味着每次启动该工具时都会延迟几秒钟。

- 如果您在大量相同的机器上运行该工具,则在每台机器上重复编译会浪费计算资源。

- 一些基于 BCC 的项目将其 eBPF 源代码和工具链打包到容器镜像中,这使得分发到每台机器变得更容易。但这并不能解决确保内核头文件存在的问题,如果在每台机器上安装多个这样的 BCC 容器,甚至可能意味着更多的重复。

- 嵌入式设备可能没有足够的内存资源来运行编译步骤。

由于这些问题,如果您计划开始开发一个重要的新 eBPF 项目,我不建议使用这种遗留的 BCC 方法,特别是如果您计划将其分发给其他人使用。在本书中,我给出了一些基于 BCC 的示例,因为这是学习 eBPF 基本概念的好方法,特别是因为 Python 用户空间代码非常紧凑且易于阅读。如果您对它比较熟悉,并且想快速完成一些事情,它也是一个很好的选择。但它并不是现代 eBPF 开发的最佳方法。

CO-RE 方法为 eBPF 程序的跨内核可移植性问题提供了更好的解决方案。

提示

github.com/iovisor/bcc 上的 BCC 项目包含各种命令行工具,用于观察 Linux 机器行为的各种信息。位于 tools 目录中的原始版本主要是使用我在本节中描述的这种传统的可移植性方法在 Python 中实现的。

在 BCC 的 libbpf-tools 目录中,您会发现这些用 C 语言编写的工具的更新版本,它们利用了 libbpf 和 CO-RE,并且不会遇到我刚刚列出的问题。它们是一组非常有用的实用程序!

CO-RE 概述